Was ist Googlebot? – Der Crawler von Google

Google Crawling und Indexierung sind Begriffe, die Sie wahrscheinlich schon einmal gehört haben, als Sie in die sehr dynamischen Gewässer der Suchmaschinenoptimierung eintauchten. Sie haben wahrscheinlich auch schon von Googles Suchmaschinen-Bots wie dem berühmten Googlebot gehört.

Aber was ist Googlebot? Und wie funktioniert Googlebot in der Suchmaschinenoptimierung?

Für das Analystenteam von Radd ist der Google-Index unser Lebenselixier, und das gilt auch für Internet-Marketing-Institutionen weltweit. Er ist das Fundament, auf dem unsere Bemühungen aufbauen. Aus diesem Grund werden wir einen tieferen Blick auf die technischen Details des Google-Indexierungsprozesses werfen und untersuchen, wie er den Erfolg von Unternehmen und Websites beeinflusst.

Für Unternehmen, die ihre Suchleistung steigern und ihre Online-Präsenz ausbauen wollen, kann es hilfreich sein zu verstehen, wie der Googlebot funktioniert.

Was ist das Crawling und die Indizierung durch Googlebot und wie wirkt es sich auf meine Website aus?

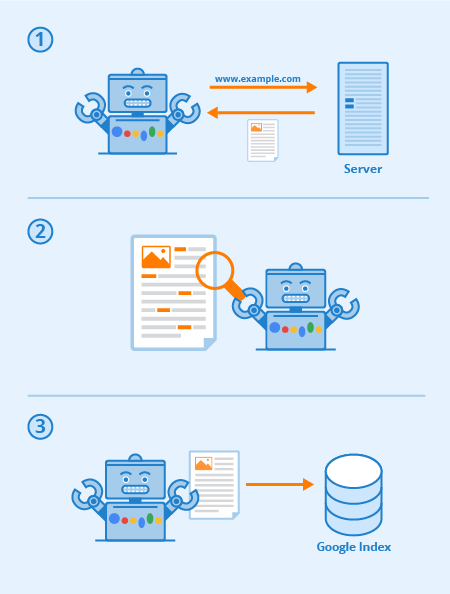

Googlebot ist eine spezielle Software, die gemeinhin als Spider bezeichnet wird und dazu dient, sich durch die Seiten öffentlicher Websites zu wühlen. Er folgt einer Reihe von Links von einer Seite zur nächsten und verarbeitet dann die gefundenen Daten in einem Sammelindex.

Diese Software ermöglicht es Google, über 1 Million GB an Informationen in nur einem Bruchteil einer Sekunde zusammenzustellen. Die Online-Suchergebnisse werden dann direkt aus diesem Index gezogen. Man kann sich das Ganze wie eine Bibliothek mit ständig wachsendem Bestand vorstellen. Googlebot ist ein allgemeiner Begriff für die Tools, die er verwendet, um Webinhalte sowohl auf dem Desktop als auch auf mobilen Geräten zu finden.

Was ist Googlebot also in Bezug auf SEO?

Die strategische Optimierung von Webseiten dient dazu, die Sichtbarkeit in den Suchergebnissen zu erhöhen. Die Art und Weise, wie Ihre Website über Textlinks abgebildet wird, kann die Gesamteffektivität des Crawlings von Googlebot erheblich verbessern. Substanzielle SEO-Praktiken umfassen Optimierungstechniken, die sowohl auf den Googlebot als auch auf die Suchmaschinen-Ergebnisseiten (SERPs) ausgerichtet sind.

Je klarer und prägnanter Ihre Sitemap und Ihr Inhalt sind, desto prominenter werden Ihre Seiten wahrscheinlich insgesamt sein.

Jede Suchmaschine (und viele andere Websites) haben Bots, und Googlebot ist der von Google. Googlebot ist ein Crawling-Bot, der, einfach ausgedrückt, von Link zu Link geht und versucht, neue URLs für seinen Index zu entdecken.

So funktioniert Googlebot: Links sind entscheidend dafür, dass er von Seite zu Seite gehen kann (und sie können auch jede Art von Link sein) – Bildlinks, Navigationsleiste, Ankertext und sogar Links, die mit gut lesbarem JavaScript versteckt sind.

Wenn diese Seiten entdeckt werden, wird ihr Inhalt von Googlebot gerendert und gelesen, so dass die Suchmaschine das Thema und den Wert für die Suchenden bestimmen kann. Eine gute SEO-Strategie bedeutet, dass Websites mit einer guten Struktur, schnellen Ladezeiten und verständlichen Inhalten für Googlebot leicht verdaulich sind und der SEO einer Website helfen können.

Via Seobility

Was ist die Crawlability einer Website?

Crawlability bezieht sich auf den Grad des Zugriffs, den Googlebot auf Ihre gesamte Website hat. Je leichter die Software Ihren Inhalt durchsuchen kann, desto besser ist Ihre Leistung in den SERPs.

Es ist jedoch möglich, dass Crawler blockiert werden, wenn auch nicht von Ihrer gesamten Website, so doch von bestimmten Seiten. Zu den häufigen Problemen, die sich negativ auf die Crawlability auswirken können, gehören Komplikationen mit einem DNS, eine falsch konfigurierte Firewall oder ein Schutzprogramm oder manchmal sogar Ihr Content-Management-System. Es sei darauf hingewiesen, dass Sie selbst beeinflussen können, welche Seiten Googlebot lesen kann und welche nicht, aber achten Sie besonders darauf, dass Ihre wichtigsten Seiten nicht blockiert werden.

Was kann ich tun, um meine Website für Googlebot zu optimieren?

Hier sind einige Tipps und Vorschläge, um Ihre Website für den Googlebot-Crawler zu optimieren:

- Ihr Inhalt muss in einem Textbrowser leicht zu erkennen sein, also machen Sie ihn nicht zu kompliziert. Googlebot hat es schwer, Websites zu crawlen, die Programme wie Ajax und (manchmal) JavaScript verwenden. Im Zweifelsfall sollten Sie es einfach halten.

- Verwenden Sie kanonische Seiten, damit Googlebot die richtige Version von doppelten Seiten findet. Bei vielen Websites ist es üblich, mehrere URLs für dieselbe Seite zu haben. Der moderne Googlebot ist sogar in der Lage zu erkennen, wann dies der Fall ist, aber viele doppelte Seiten unter mehreren URLs können ihn manchmal verwirren, seine Indexierungsgeschwindigkeit verlangsamen und Ihr Crawl-Budget verringern. Deshalb ist die Kanonisierung in den meisten Fällen die beste SEO-Praxis.

- Leiten Sie Googlebot mithilfe Ihrer robots.txt-Datei oder Meta-Robots-Tags durch Ihre Website. Wenn Sie den Crawler von unwichtigen Seiten fernhalten, kann die Software ihre Zeit mit den wertvolleren Inhalten verbringen und die Struktur Ihrer Website besser verstehen. (In den letzten Jahren hat Google die Wirkung von robots.txt für das Blockieren von Seiten aus dem Index heruntergespielt, was in bestimmten Fällen nicht mehr funktioniert; die beste Praxis ist, stattdessen “no-index”-Direktiven zu verwenden)

- Frischer Inhalt. Google liebt frische und relevante Inhalte. Wenn Sie alte Seiten aktualisieren oder neue Seiten erstellen, wecken Sie das Interesse des Crawlers. Je häufiger Sie gecrawlt werden, desto mehr Chancen haben Sie, Ihre Leistung zu steigern. Dies gilt jedoch nur, solange Sie qualitativ hochwertige Aktualisierungen vornehmen. Achten Sie immer darauf, dass Ihre Texte gut geschrieben und nicht mit Schlüsselwörtern überfrachtet sind. Schlecht geschriebener Inhalt wird sich nur negativ auswirken.

- Interne Verlinkung. Interne Verlinkung durch Ankertext-Links oder ATLs hilft dem Crawler, sich durch Ihre Website zu bewegen. Ein engmaschiges Verlinkungssystem kann das Crawlen von Googlebot wesentlich effektiver machen. Sie sollten ATLs mit Bedacht verfassen. Verlinken Sie nur auf Seiten, die für Ihren Inhalt oder Ihr Produkt relevant sind, und stellen Sie sicher, dass das Ziel nicht anders als über die Navigationsleiste der aktuellen Seite erreicht werden kann.

- Senden Sie eine Sitemap. Sitemaps sind Dateien, die auf dem Server einer Website gehostet werden und die alle URLs der Website auflisten (oder zumindest alle, die der Eigentümer der Website angeben möchte). Sitemaps sind gut für die Suchmaschinenoptimierung, da sie dem Googlebot eine leicht auffindbare und leicht zu verdauende Liste aller Ihrer wichtigsten Seiten liefern. Mit einer Sitemap werden Websites wahrscheinlich schneller und häufiger indiziert.

Die Leistung Ihrer Website innerhalb von Google ist eine vielschichtige Sache, und es ist wichtig, daran zu denken, dass Googlebot immer crawlt.

Die verschiedenen Arten von Googlebots

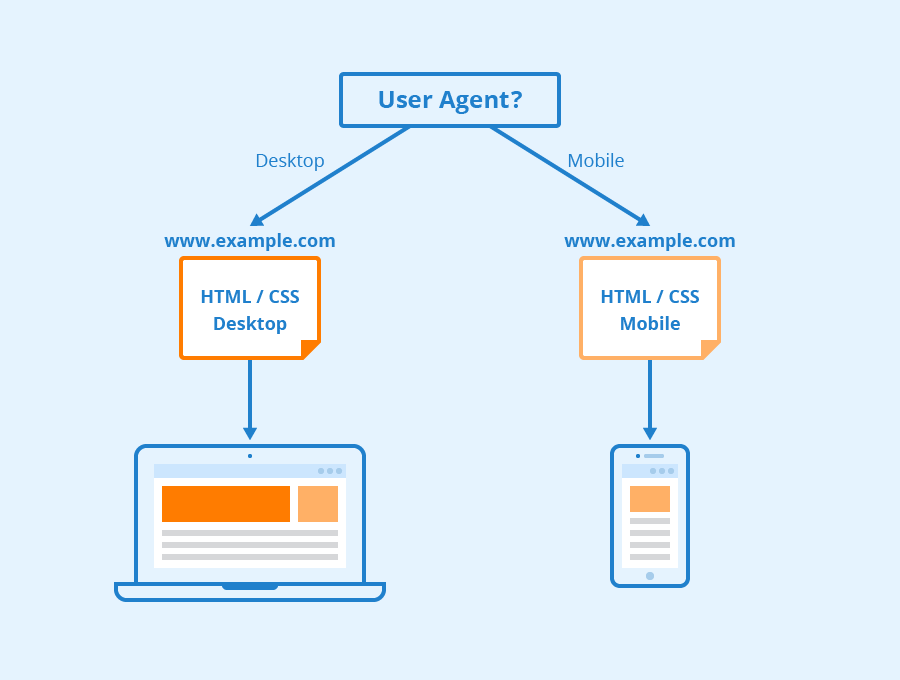

Nach Angaben von Google werden alle Websites wahrscheinlich sowohl von Googlebot Desktop als auch Googlebot Smartphone gecrawlt. Variationen seiner Crawler, die darauf ausgelegt sind, unterschiedliche Informationen für verschiedene Geräte zu sammeln. Als Google 2018 die Mobile-First-Indexierung für seinen Index ankündigte, bedeutete dies, dass Websites mit mobilen Versionen standardmäßig in den Index aufgenommen werden – ein Signal für Online-Unternehmen und Websites, dass der mobile Verkehr immer dominanter wird.

Googlebot verwendet verschiedene “Benutzer-Agenten”, um verschiedene Geräte oder Technologien zu imitieren, damit er sehen kann, wie Webinhalte auf diesen verschiedenen Softwares erscheinen.

Via Seobility

Was ist Googlebot Smartphone? Wie viele Googlebots gibt es eigentlich?

Google hat sechzehn verschiedene Bots, die für verschiedene Formen der Darstellung und des Crawlings von Webseiten konzipiert sind. Die Wahrheit ist, dass Sie Ihre Website für SEO nur selten für einen dieser Bots anders einrichten müssen. Jeder dieser Bots kann über Ihre robots.txt-Datei oder Ihre Meta-Befehle anders behandelt werden, aber wenn Sie keine Direktiven für einen bestimmten Bot angeben, werden sie alle gleich behandelt.

Googlebot läuft auf Googles Chromium-Rendering-Engine, die von Zeit zu Zeit aktualisiert wird, um sicherzustellen, dass sie in der Lage ist, moderne Website-Codierungsparameter und -Stile zu verstehen und sicherzustellen, dass sie moderne Seiten schnell rendern kann.

Googlebot’s Chromium ist zu dem geworden, was Google eine “immergrüne” Engine nennt, was bedeutet, dass es immer die neueste Chromium-basierte Engine für das Rendering von Websites auf die gleiche Weise wie der Chrome-Browser (zusammen mit anderen Benutzer-Agenten für verschiedene andere gängige Webbrowser) ausführen wird. Googles langjähriges Ziel ist es, Websites und Webseiten so zu rendern und zu verstehen, wie es Menschen tun. Das bedeutet, dass Googlebot Seiten auf die gleiche Weise versteht, wie sie in modernen Webbrowsern angezeigt werden.

Mehr erfahren

So, was ist Googlebot in SEO? Kontaktieren Sie uns, um weitere Informationen zu erhalten.

Bei Radd Interactive arbeitet unser Analystenteam an strategischen Optimierungen, die die Leistung einer Website als Ganzes verbessern und dabei den Appetit von Googlebot auf frische, relevante und leicht verdauliche Inhalte berücksichtigen.

Die Optimierung für den Googlebot-Crawler hilft sicherzustellen, dass Ihre Website sowohl gründlich als auch effizient gecrawlt und indiziert wird, um die bestmöglichen Ergebnisse zu erzielen.