Qu’est-ce que Googlebot ? – Apprendre à connaître le crawler de Google

Le crawling et l’indexation de Google sont des termes que vous avez probablement entendus en plongeant dans les eaux profondément dynamiques de l’optimisation des moteurs de recherche. Vous avez aussi probablement entendu parler des robots du moteur de recherche de Google, comme son célèbre Googlebot.

Mais qu’est-ce que Googlebot ? Et comment Googlebot fonctionne-t-il dans le référencement ?

Pour l’équipe d’analystes de Radd, l’index de Google est notre source de vie, et il en va de même pour les institutions de marketing internet du monde entier. C’est la base sur laquelle nos efforts sont construits. Cela étant dit, nous allons examiner plus en profondeur les aspects techniques du processus d’indexation de Google et explorer les façons dont il affecte le succès des entreprises et des sites Web.

Pour les entreprises qui veulent développer leurs performances de recherche et accroître leur présence en ligne, comprendre le fonctionnement de Googlebot peut aider.

Qu’est-ce que l’exploration et l’indexation de Googlebot, et comment cela affecte-t-il mon site ?

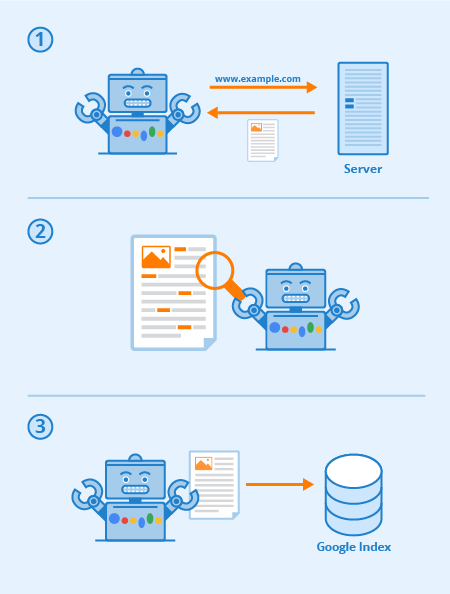

Googlebot est un logiciel spécial, communément appelé araignée, conçu pour parcourir les pages des sites Web publics. Il suit une série de liens partant d’une page à l’autre, puis traite les données qu’il trouve dans un index collectif.

Ce logiciel permet à Google de compiler plus d’un million de Go d’informations en seulement une fraction de seconde. Les résultats de recherche en ligne sont ensuite tirés directement de cet index. Une façon amusante et facile d’y penser est comme une bibliothèque avec un inventaire en constante expansion. Googlebot est un terme générique pour désigner les outils qu’il utilise pour découvrir le contenu Web dans les paramètres de bureau et mobiles.

Avec cela à l’esprit, alors qu’est-ce que Googlebot en termes de référencement ?

L’optimisation stratégique des pages Web fonctionne pour augmenter la visibilité parmi les résultats de recherche Web. La façon dont votre site web est cartographié via des liens textuels peut grandement améliorer l’efficacité globale du crawl de Googlebot. Les pratiques de référencement substantiel comprennent des techniques d’optimisation axées à la fois sur Googlebot et sur les pages de résultats des moteurs de recherche (SERPs).

En fin de compte, plus votre sitemap et votre contenu sont clairs et concis, plus vos pages sont susceptibles d’être mises en évidence dans l’ensemble.

Chaque moteur de recherche (et de nombreux autres sites Web) a des robots, et Googlebot est celui de Google. Googlebot est un robot d’exploration qui, en termes simples, va de lien en lien en essayant de découvrir de nouvelles URL pour son index.

Voici comment Googlebot fonctionne : les liens sont essentiels pour lui permettre d’aller de page en page (et ils peuvent être n’importe quel type de lien aussi) – liens d’image, nav-bar, texte d’ancrage, et même des liens cachés avec du JavaScript correctement lisible.

Lorsque ces pages sont découvertes, leur contenu est rendu par Googlebot et son contenu est lu afin que le moteur de recherche puisse déterminer son sujet ainsi que sa valeur pour les chercheurs. Une bonne stratégie de référencement signifie que les sites dotés d’une bonne structure, de temps de chargement rapides et d’un contenu compréhensible sont faciles à digérer pour Googlebot et peuvent aider au référencement d’un site.

Via Seobility

Qu’est-ce que la crawlabilité d’un site web ?

La crawlabilité fait référence au degré d’accès de Googlebot à l’ensemble de votre site. Plus il est facile pour le logiciel de passer au crible votre contenu, meilleures seront vos performances dans les SERPs.

Cependant, il est possible que les crawlers soient bloqués, si ce n’est de votre site dans son ensemble, certainement de certaines pages. Les problèmes courants qui peuvent affecter négativement votre crawlabilité incluent des complications avec un DNS, un pare-feu ou un programme de protection mal configuré, ou parfois même votre système de gestion de contenu. Il convient de noter que vous pouvez personnellement manipuler les pages que Googlebot peut ou ne peut pas lire, mais faites très attention à ce que vos pages les plus importantes ne soient pas bloquées.

Que puis-je faire pour optimiser mon site pour Googlebot ?

Voici quelques conseils et suggestions en ce qui concerne l’optimisation de votre site Web pour l’engin d’exploration Googlebot :

- Votre contenu doit être facilement visible dans un navigateur de texte, donc ne le rendez pas trop compliqué. Googlebot a du mal à explorer les sites qui utilisent des programmes tels que Ajax et (parfois) JavaScript. Dans le doute, restez simple.

- Utilisez des pages canoniques pour aider Googlebot à trouver la bonne version des pages dupliquées. Pour de nombreux sites Web, il est courant d’avoir plusieurs URL pour la même page. Googlebot moderne est même capable de savoir quand cela se produit, mais avoir des pages en double sur plusieurs URL peut parfois le perturber, ralentir sa vitesse d’indexation et réduire votre budget de crawl. C’est pourquoi la canonicalisation est la meilleure pratique pour le référencement dans la plupart des cas.

- Guider Googlebot à travers votre site en utilisant votre fichier robots.txt ou les balises meta robots. En bloquant le robot d’exploration des pages sans importance, le logiciel passera son temps sur votre contenu plus précieux et l’aidera à comprendre la structure de votre site. (Ces dernières années, Google a minimisé l’effet de robots.txt pour bloquer les pages de l’index, ce qui ne fonctionne plus pour certains, la meilleure pratique est d’utiliser les directives “no-index” à la place)

- Contenu frais. Google aime le contenu frais et pertinent. La mise à jour d’anciennes pages ou la création de nouvelles pages suscitera l’intérêt du crawler. Plus vous êtes crawlé fréquemment, plus vous avez de chances d’augmenter vos performances. Toutefois, cela ne vaut que si vous effectuez des mises à jour de qualité. Veillez toujours à ce que votre texte soit bien écrit et ne soit pas surchargé de mots clés. Un contenu mal écrit n’aura qu’un effet négatif.

- Lien interne. La liaison interne par le biais de liens de texte d’ancrage, ou ATL, aide à diriger le crawler à travers votre site. Un système de liens étroitement consolidé peut rendre le crawl de Googlebot beaucoup plus efficace. Vous devez faire preuve de discernement lorsque vous rédigez des liens d’ancrage. Ne créez que des liens vers des pages qui sont pertinentes pour votre contenu ou votre produit, et assurez-vous que la destination ne peut pas être autrement accessible à partir de la barre de navigation de la page actuelle.

- Soumettre un sitemap. Les sitemaps sont des fichiers hébergés sur le serveur d’un site qui répertorient toutes les URL du site (ou toutes celles que les propriétaires du site choisissent d’inclure au moins). Les sitemaps sont bons pour le référencement car ils donnent à Googlebot une liste facile à trouver et à digérer de toutes vos pages les plus importantes. Avec un sitemap, les sites seront probablement indexés plus rapidement et plus fréquemment.

La performance de votre site au sein de Google est une chose à plusieurs niveaux, et il est important de se rappeler que Googlebot est toujours en train d’explorer.

Les différents types de Googlebots

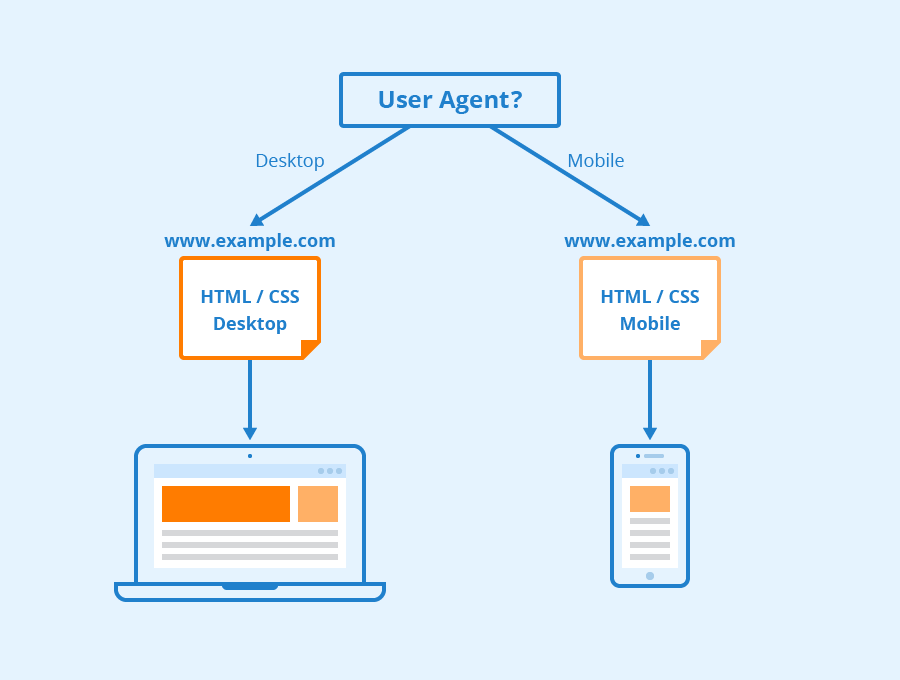

Selon Google, tous les sites Web vont probablement être explorés à la fois par Googlebot Desktop et Googlebot Smartphone. Des variations de ses crawlers qui sont conçus pour collecter différentes informations pour différents appareils. Lorsque Google a annoncé l’indexation mobile-first pour son index en 2018, cela signifiait que les sites Web avec des versions mobiles auraient cette version entrée dans son index par défaut – signalant aux entreprises et aux sites Web en ligne que le trafic mobile devenait de plus en plus dominant.

Googlebot utilise différents “user-agents” pour imiter différents appareils ou technologies afin de pouvoir voir comment le contenu web apparaît à ces différents logiciels.

Via Seobility

Qu’est-ce que Googlebot Smartphone ? En fait, combien de Googlebots y a-t-il ?

Google a seize bots différents conçus pour diverses formes de rendu et d’exploration de sites. La vérité est que pour le référencement, vous avez rarement besoin de configurer votre site différemment pour l’un d’entre eux. Chacun de ces bots peut être géré différemment à l’aide de votre fichier robots.txt ou de vos méta-commandes, mais à moins que vous ne spécifiez des directives pour un bot particulier, ils seront tous traités de la même manière.

Googlebot fonctionne sur le moteur de rendu Chromium de Google qui est mis à jour de temps en temps pour s’assurer qu’il est capable de comprendre les paramètres et les styles de codage des sites Web modernes et pour s’assurer qu’il peut rendre rapidement les pages modernes.

Le Chromium de Googlebot est devenu ce que google appelle un moteur “evergreen”, ce qui signifie qu’il exécutera toujours le dernier moteur basé sur Chromium pour rendre les sites web de la même manière que le navigateur Chrome (ainsi que d’autres user-agents pour divers autres navigateurs web courants). L’objectif de longue date de Google est d’être en mesure de rendre et de comprendre les sites Web et les pages Web de la même manière que les humains, ce qui signifie que Googlebot comprendra les pages à peu près de la même manière qu’elles apparaissent dans les navigateurs Web modernes.

En savoir plus

Alors, qu’est-ce que Googlebot dans le référencement ? Contactez-nous pour obtenir plus d’informations.

À Radd Interactive, notre équipe d’analystes travaille à effectuer des optimisations stratégiques qui améliorent les performances d’un site dans son ensemble, en tenant compte de l’appétit de Googlebot pour un contenu frais, pertinent et facile à digérer.

L’optimisation pour le robot d’exploration Googlebot permet de s’assurer que votre site Web est exploré et indexé à la fois de manière approfondie et efficace pour obtenir les meilleurs résultats possibles.