Cos’è Googlebot? – Conoscere il Crawler di Google

Il crawling e l’indicizzazione di Google sono termini che probabilmente hai sentito mentre ti immergevi nelle acque profondamente dinamiche dell’ottimizzazione dei motori di ricerca. Probabilmente hai anche sentito parlare dei bot dei motori di ricerca di Google come il suo famoso Googlebot.

Ma cos’è Googlebot? E come funziona Googlebot nel SEO?

Per il team di analisti di Radd, l’indice di Google è la nostra linfa vitale, e lo stesso vale per le istituzioni di internet marketing di tutto il mondo. È la base su cui sono costruiti i nostri sforzi. Detto questo, daremo uno sguardo più profondo ai tecnicismi del processo di indicizzazione di Google ed esploreremo i modi in cui influisce sul successo di aziende e siti web.

Per le aziende che vogliono espandere le loro prestazioni di ricerca e far crescere la loro presenza online, capire come funziona Googlebot può aiutare.

Cos’è il crawling e l’indicizzazione di Googlebot, e come influisce sul mio sito?

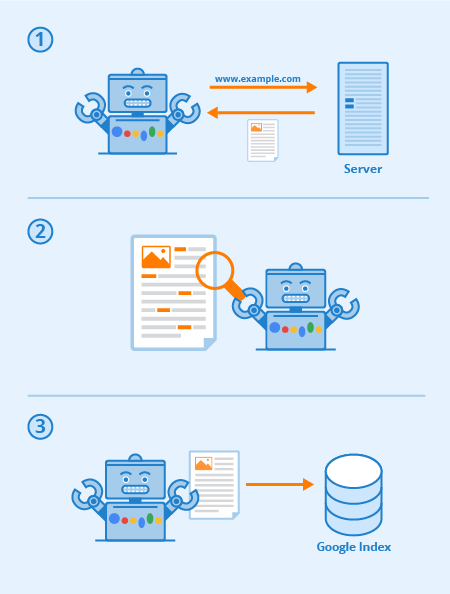

Googlebot è un software speciale, comunemente chiamato spider, progettato per scorrere le pagine dei siti web pubblici. Segue una serie di link partendo da una pagina all’altra, e poi elabora i dati che trova in un indice collettivo.

Questo software permette a Google di compilare oltre 1 milione di GB di informazioni in una frazione di secondo. I risultati delle ricerche online sono poi estratti direttamente da questo indice. Un modo divertente e facile per pensarlo è come una biblioteca con un inventario in continua espansione. Googlebot è un termine generico per gli strumenti che utilizza per scoprire i contenuti web in entrambe le impostazioni desktop e mobile.

Con questo in mente, allora cos’è Googlebot in termini SEO?

L’ottimizzazione strategica delle pagine web lavora per aumentare la visibilità tra i risultati di ricerca web. Il modo in cui il tuo sito web è mappato attraverso i link di testo può migliorare notevolmente l’efficacia complessiva della scansione di Googlebot. Le pratiche SEO sostanziali includono tecniche di ottimizzazione orientate sia verso Googlebot che verso le pagine dei risultati dei motori di ricerca (SERP).

In definitiva, più chiara e concisa è la tua sitemap e il tuo contenuto, più è probabile che le tue pagine siano complessivamente importanti.

Ogni motore di ricerca (e molti altri siti web) ha dei bot, e Googlebot è quello di Google. Googlebot è un bot di crawling che in termini semplici va da un link all’altro cercando di scoprire nuovi URL per il suo indice.

Ecco come funziona Googlebot: i link sono fondamentali per permettergli di andare da una pagina all’altra (e possono anche essere qualsiasi tipo di link) – link immagine, nav-bar, anchor-text, e anche link nascosti con JavaScript correttamente leggibile.

Quando queste pagine vengono scoperte il loro contenuto viene reso da Googlebot e il suo contenuto viene letto in modo che il motore di ricerca possa determinarne l’argomento e il valore per chi effettua le ricerche. Una corretta strategia SEO significa che i siti con una buona struttura, tempi di caricamento veloci e contenuti comprensibili sono facili da digerire per Googlebot e possono aiutare il SEO di un sito.

Via Seobility

Cos’è la crawlability di un sito web?

Crawlability si riferisce al grado di accesso che Googlebot ha al tuo intero sito. Più facile è per il software vagliare il tuo contenuto, migliore sarà la tua performance nelle SERP.

Tuttavia, è possibile che i crawler siano bloccati, se non dal tuo sito nel suo complesso, certamente da alcune pagine selezionate. I problemi comuni che possono influenzare negativamente la tua crawlabilità includono complicazioni con un DNS, un firewall o un programma di protezione mal configurato, o a volte anche il tuo sistema di gestione dei contenuti. Va notato che è possibile manipolare personalmente quali pagine Googlebot può e non può leggere, ma prestare particolare attenzione per garantire che le pagine più importanti non vengano bloccate.

Cosa posso fare per ottimizzare il mio sito per Googlebot?

Ecco alcuni consigli e suggerimenti per ottimizzare il tuo sito per il crawler Googlebot:

- Il tuo contenuto deve essere facilmente visibile in un browser di testo, quindi non renderlo troppo complicato. Googlebot ha difficoltà a scansionare i siti che utilizzano programmi come Ajax e (a volte) JavaScript. In caso di dubbio, mantenetelo semplice.

- Utilizzate le pagine canoniche per aiutare Googlebot a trovare la versione giusta delle pagine duplicate. Per molti siti web è comune avere più URL per la stessa pagina. Il moderno Googlebot è anche in grado di sapere quando questo accade, ma avere tonnellate di pagine duplicate su più URL può talvolta confonderlo, rallentare la sua velocità di indicizzazione, e ridurre il vostro budget di crawl. Ecco perché la canonicalizzazione è una best-practice per il SEO nella maggior parte dei casi.

- Guida Googlebot attraverso il tuo sito utilizzando il tuo file robots.txt o i meta tag robots. Bloccando il crawler dalle pagine non importanti, il software passerà il suo tempo sui contenuti di maggior valore e lo aiuterà a capire la struttura del tuo sito. (Negli ultimi anni Google ha ridimensionato l’effetto del robots.txt per bloccare le pagine dall’indice che non funziona più per certo, la pratica migliore è quella di usare invece le direttive “no-index”)

- Contenuto fresco. Google ama i contenuti freschi e rilevanti. Aggiornare le vecchie pagine o crearne di nuove farà scattare l’interesse del crawler. Più frequentemente vieni scansionato, più possibilità hai di aumentare le prestazioni. Tuttavia, questo vale solo fino a quando si fanno aggiornamenti di qualità. Assicurati sempre che il tuo testo sia ben scritto e non sovraccarico di parole chiave. Un contenuto scritto male avrà solo un effetto negativo.

- Internal Linking. Il collegamento interno per mezzo di link di testo di ancoraggio, o ATL, aiuta a dirigere il crawler attraverso il tuo sito. Un sistema di collegamento strettamente consolidato può rendere la scansione di Googlebot molto più efficace. Bisogna essere deliberati quando si scrivono gli ATL. Collega solo le pagine che sono rilevanti per il tuo contenuto o prodotto, e assicurati che la destinazione non sia altrimenti accessibile dalla barra di navigazione della pagina corrente.

- Invio di una sitemap. Le sitemap sono file ospitati sul server di un sito che elencano tutti gli URL del sito (o tutti quelli che i proprietari del sito scelgono di includere almeno). Le sitemap sono buone per il SEO poiché danno a Googlebot una lista facile da trovare e facile da digerire di tutte le vostre pagine più importanti. Con una sitemap, i siti saranno probabilmente indicizzati più rapidamente e più frequentemente.

La performance del vostro sito all’interno di Google è una cosa a più livelli, ed è importante ricordare che Googlebot sta sempre strisciando.

I diversi tipi di Googlebots

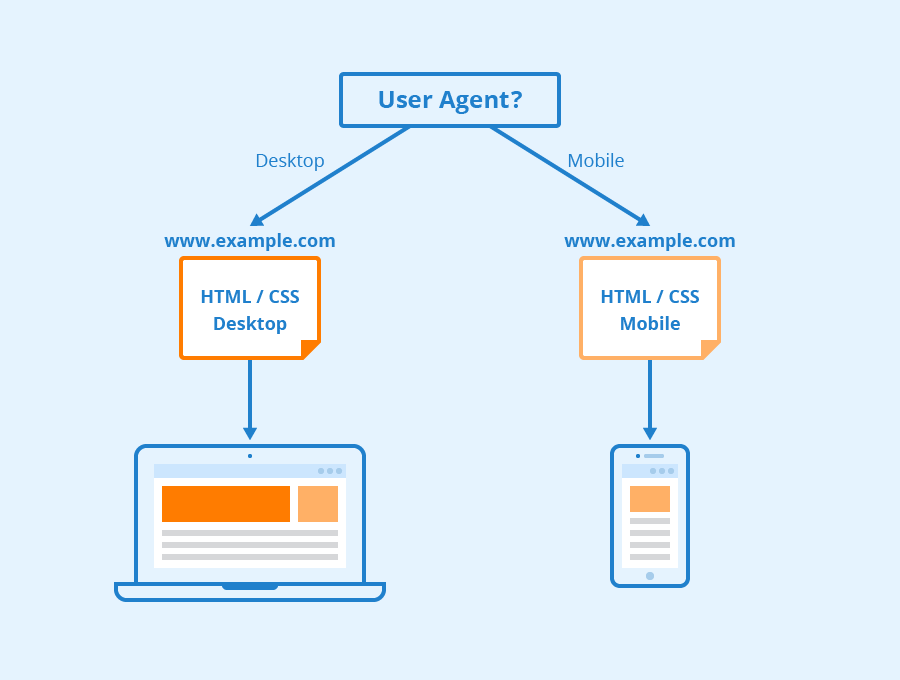

Secondo Google tutti i siti web stanno per essere strisciati sia da Googlebot Desktop che da Googlebot Smartphone. Variazioni dei suoi crawler che sono progettati per raccogliere informazioni diverse per i diversi dispositivi. Quando Google ha annunciato l’indicizzazione mobile-first per il suo indice nel 2018, significava che i siti web con versioni mobili avrebbero avuto quella versione inserita nel suo indice per impostazione predefinita – segnalando alle aziende online e ai siti web che il traffico mobile stava diventando sempre più dominante.

Googlebot utilizza diversi “user-agent” per imitare diversi dispositivi o tecnologie in modo da poter vedere come i contenuti web appaiono a quei diversi software.

Via Seobility

Cosa è Googlebot Smartphone? In effetti, quanti Googlebot ci sono?

Google ha sedici diversi bot progettati per varie forme di rendering e crawling del sito. La verità è che per il SEO raramente hai bisogno di impostare il tuo sito in modo diverso per ognuno di questi. Ognuno di questi bot può essere gestito in modo diverso utilizzando il file robots.txt o i meta comandi, ma a meno che non si specifichino direttive per un bot particolare, saranno tutti trattati allo stesso modo.

Googlebot gira sul motore di rendering Chromium di Google che viene aggiornato di tanto in tanto per garantire che sia in grado di comprendere i parametri e gli stili di codifica dei siti web moderni e per garantire che possa rendere rapidamente le pagine moderne.

Il Chromium di Googlebot è diventato ciò che Google chiama un motore “evergreen”, il che significa che eseguirà sempre l’ultimo motore basato su Chromium per il rendering dei siti web come fa il browser Chrome (insieme ad altri user-agent per vari altri browser web comuni). L’obiettivo di lunga data di Google è quello di essere in grado di rendere e capire i siti web e le pagine web come fanno gli esseri umani, questo significa che Googlebot capirà le pagine più o meno nello stesso modo in cui appaiono nei moderni browser web.

Impara di più

Cos’è Googlebot nel SEO? Contattateci per avere maggiori informazioni.

A Radd Interactive, il nostro team di analisti lavora per eseguire ottimizzazioni strategiche che migliorano le prestazioni di un sito nel suo complesso, tenendo in considerazione l’appetito di Googlebot per contenuti freschi, rilevanti e facili da digerire.

Ottimizzare per il crawler Googlebot aiuta a garantire che il tuo sito venga scansionato e indicizzato in modo completo ed efficiente per ottenere i migliori risultati possibili.

Per saperne di più