Impara a conoscere ciascuna delle 5 generazioni di computer e i principali sviluppi tecnologici che hanno portato ai dispositivi informatici che usiamo oggi.

La storia dello sviluppo dei computer è un argomento di informatica che viene spesso utilizzato per fare riferimento alle diverse generazioni di dispositivi informatici. Ognuna delle cinque generazioni di computer è caratterizzata da un importante sviluppo tecnologico che ha cambiato fondamentalmente il modo in cui i computer operano.

La storia dello sviluppo dei computer è un argomento di informatica che viene spesso utilizzato per fare riferimento alle diverse generazioni di dispositivi informatici. Ognuna delle cinque generazioni di computer è caratterizzata da un importante sviluppo tecnologico che ha cambiato fondamentalmente il modo in cui i computer operano.

La maggior parte dei principali sviluppi dagli anni ’40 ad oggi hanno portato a dispositivi informatici sempre più piccoli, più economici, più potenti e più efficienti.

- Quali sono le cinque generazioni di computer?

- Diamo un’occhiata…

- Lista di controllo delle cinque generazioni di computer

- Per iniziare: Termini chiave da conoscere

- Prima generazione: Tubi a vuoto (1940-1956)

- Seconda generazione: Transistor (1956-1963)

- Dal binario all’assemblaggio

- Terza generazione: Circuiti Integrati (1964-1971)

- Quarta generazione: Microprocessori (1971-oggi)

- Quinta generazione: Intelligenza artificiale (presente e oltre)

- I migliori 10 articoli di Webopedia sulle certificazioni IT e informatiche

Quali sono le cinque generazioni di computer?

In questa guida allo studio di Webopedia, imparerai di più su ciascuna delle cinque generazioni di computer e sui progressi della tecnologia che hanno portato allo sviluppo dei molti dispositivi informatici che usiamo oggi. Il nostro viaggio nelle cinque generazioni di computer inizia nel 1940 con i circuiti a valvole e arriva fino ai giorni nostri e oltre con i sistemi e i dispositivi di intelligenza artificiale (AI).

Diamo un’occhiata…

Lista di controllo delle cinque generazioni di computer

- Inizio: Termini chiave da conoscere

- Prima generazione: Tubi a vuoto

- Seconda generazione: Transistor

- Terza generazione: Circuiti integrati

- Quarta generazione: Microprocessori

- Quinta generazione: Intelligenza Artificiale

Per iniziare: Termini chiave da conoscere

Le seguenti definizioni tecnologiche vi aiuteranno a capire meglio le cinque generazioni dell’informatica:

- computer

- microprocessore

- tamburi magnetici

- binario

- circuito integrato

- semiconduttore

- nanotecnologia

- linguaggio macchina

- linguaggio di assemblaggio

- intelligenza artificiale

Prima generazione: Tubi a vuoto (1940-1956)

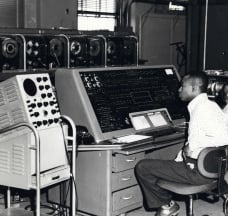

I primi sistemi informatici utilizzavano tubi a vuoto per i circuiti e tamburi magnetici per la memoria, ed erano spesso enormi, occupando intere stanze. Questi computer erano molto costosi da far funzionare e, oltre ad utilizzare una grande quantità di elettricità, i primi computer generavano molto calore, che era spesso la causa di malfunzionamenti.

I computer di prima generazione si basavano sul linguaggio macchina, il linguaggio di programmazione di livello più basso compreso dai computer, per eseguire le operazioni, e potevano risolvere solo un problema alla volta. Gli operatori impiegavano giorni o addirittura settimane per impostare un nuovo problema. L’input era basato su schede perforate e nastro di carta, e l’output veniva visualizzato su stampe.

I computer UNIVAC ed ENIAC sono esempi di dispositivi informatici di prima generazione. L’UNIVAC fu il primo computer commerciale consegnato a un cliente commerciale, l’Ufficio Censimento degli Stati Uniti nel 1951.

Lettura consigliata: Definizione ENIAC di Webopedia

Seconda generazione: Transistor (1956-1963)

Il mondo avrebbe visto i transistor sostituire i tubi a vuoto nella seconda generazione di computer. Il transistor fu inventato ai Bell Labs nel 1947 ma non vide un uso diffuso nei computer fino alla fine degli anni ’50.

Il transistor era di gran lunga superiore al tubo a vuoto, permettendo ai computer di diventare più piccoli, più veloci, più economici, più efficienti dal punto di vista energetico e più affidabili dei loro predecessori di prima generazione. Anche se il transistor generava ancora una grande quantità di calore che sottoponeva il computer a danni, era un grande miglioramento rispetto al tubo a vuoto. I computer di seconda generazione si basavano ancora su schede perforate per l’input e stampe per l’output.

Dal binario all’assemblaggio

I computer di seconda generazione passarono dal criptico linguaggio macchina binario ai linguaggi simbolici, o assembly, che permettevano ai programmatori di specificare istruzioni in parole. In questo periodo si stavano sviluppando anche linguaggi di programmazione di alto livello, come le prime versioni di COBOL e FORTRAN. Questi furono anche i primi computer che memorizzavano le loro istruzioni nella loro memoria, che passò da un tamburo magnetico alla tecnologia del nucleo magnetico.

I primi computer di questa generazione furono sviluppati per l’industria dell’energia atomica.

Terza generazione: Circuiti Integrati (1964-1971)

Lo sviluppo del circuito integrato fu il segno distintivo della terza generazione di computer. I transistor furono miniaturizzati e collocati su chip di silicio, chiamati semiconduttori, che aumentarono drasticamente la velocità e l’efficienza dei computer.

Invece di schede perforate e stampe, gli utenti interagivano con i computer di terza generazione attraverso tastiere e monitor e si interfacciavano con un sistema operativo, che permetteva al dispositivo di eseguire molte applicazioni diverse contemporaneamente con un programma centrale che controllava la memoria. I computer per la prima volta divennero accessibili a un pubblico di massa perché erano più piccoli e più economici dei loro predecessori.

Lo sapevi… ? Un circuito integrato (IC) è un piccolo dispositivo elettronico fatto di un materiale semiconduttore. Il primo circuito integrato è stato sviluppato nel 1950 da Jack Kilby della Texas Instruments e Robert Noyce della Fairchild Semiconductor.

Quarta generazione: Microprocessori (1971-oggi)

Il microprocessore ha inaugurato la quarta generazione di computer, poiché migliaia di circuiti integrati sono stati costruiti su un singolo chip di silicio. Ciò che nella prima generazione riempiva un’intera stanza, ora poteva stare nel palmo di una mano. Il chip Intel 4004, sviluppato nel 1971, collocava tutti i componenti del computer, dall’unità centrale di elaborazione e dalla memoria ai controlli di input/output su un singolo chip.

Nel 1981, IBM introdusse il suo primo computer per l’utente domestico, e nel 1984 Apple introdusse il Macintosh. I microprocessori uscirono anche dal regno dei computer da tavolo per entrare in molte aree della vita, dato che sempre più prodotti di uso quotidiano cominciarono a usare microprocessori.

Quando questi piccoli computer diventarono più potenti, potevano essere collegati tra loro per formare reti, cosa che alla fine portò allo sviluppo di Internet. I computer di quarta generazione videro anche lo sviluppo delle GUI, del mouse e dei dispositivi palmari.

Quinta generazione: Intelligenza artificiale (presente e oltre)

I dispositivi informatici di quinta generazione, basati sull’intelligenza artificiale, sono ancora in fase di sviluppo, anche se ci sono alcune applicazioni, come il riconoscimento vocale, che vengono utilizzate oggi. L’uso dell’elaborazione parallela e dei superconduttori sta aiutando a rendere l’intelligenza artificiale una realtà.

Il calcolo quantistico e la nanotecnologia molecolare cambieranno radicalmente il volto dei computer negli anni a venire. L’obiettivo della quinta generazione di computer è quello di sviluppare dispositivi che rispondano agli input del linguaggio naturale e che siano in grado di apprendere e auto-organizzarsi.

I migliori 10 articoli di Webopedia sulle certificazioni IT e informatiche

- Perché hai bisogno di una certificazione IT

- Elenco enorme di certificazioni informatiche

- Certificazione AWS

- Ingegneria informatica Engineering

- Database Administrator (DBA)

- Social Media Manager

- Mobile Developer

- User Experience Designer (UX)

- Software Engineer

- Certified Ethical Hacker (CEH)