O que é o Googlebot? – Conhecendo o Crawler do Google

Google crawling e indexing são termos que você provavelmente já ouviu enquanto mergulhava nas águas profundamente dinâmicas da otimização para mecanismos de busca. Você provavelmente também já ouviu falar sobre os bots do Google como seu famoso Googlebot.

Mas o que é o Googlebot? E como funciona o Googlebot em SEO?

Para a equipe de analistas da Radd, o índice do Google é a nossa força vital, e o mesmo vale para as instituições de marketing da internet em todo o mundo. É a base sobre a qual os nossos esforços são construídos. Dito isto, vamos aprofundar os aspectos técnicos do processo de indexação do Google e explorar as formas como este afecta o sucesso das empresas e websites.

Para as empresas que querem expandir o seu desempenho de pesquisa e aumentar a sua presença online, compreender como o Googlebot funciona pode ajudar.

O que é o Googlebot rastreando e indexando, e como isso afeta meu site?

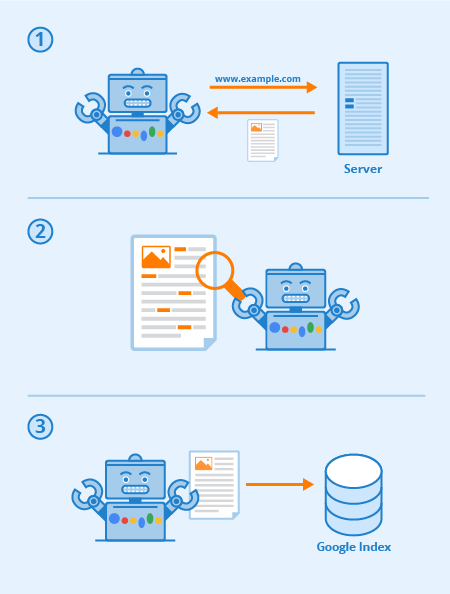

Googlebot é um software especial, comumente chamado de aranha, projetado para rastrear as páginas de sites públicos. Ele segue uma série de links começando de uma página para a próxima, e depois processa os dados que encontra em um índice coletivo.

Este software permite ao Google compilar mais de 1 milhão de GB de informação em apenas uma fração de segundo. Os resultados da pesquisa on-line são então puxados diretamente deste índice. Uma forma divertida e fácil de pensar é como uma biblioteca com um inventário em constante expansão. Googlebot é um termo genérico para as ferramentas que ele usa para descobrir conteúdo web tanto em ambientes de trabalho como móveis.

Com isso em mente, então o que é Googlebot em termos de SEO?

A otimização estratégica de páginas web funciona para aumentar a visibilidade entre os resultados da pesquisa web. A forma como o seu site é mapeado através de links de texto pode aumentar muito a eficácia geral do rastreamento do Googlebot. As práticas substanciais de SEO incluem técnicas de otimização voltadas tanto para o Googlebot quanto para as páginas de resultados dos mecanismos de busca (SERPs).

Ultimamente, quanto mais claro e conciso for o mapa e o conteúdo do seu site, mais proeminentes serão as suas páginas em geral.

Todos os mecanismos de busca (e muitos outros sites) têm bots, e o Googlebot é do Google. Googlebot é um bot que em termos simples vai de link para link tentando descobrir novas URLs para seu índice.

Aqui está como o Googlebot funciona: links são críticos para permitir que ele vá de página em página (e eles podem ser qualquer tipo de link também) – links de imagens, barra de navegação, âncora-texto, e até mesmo links ocultos com JavaScript devidamente legível.

Quando estas páginas são descobertas, o seu conteúdo é renderizado pelo Googlebot e o seu conteúdo é lido para que o motor de busca possa determinar o seu assunto, bem como o seu valor para os pesquisadores. Uma estratégia SEO adequada significa que sites com boa estrutura, tempos de carregamento rápidos e conteúdo compreensível são fáceis de digerir pelo Googlebot e podem ajudar o SEO de um site.

Via Seobility

O que é a capacidade de rastreamento do site?

A capacidade de rastreamento refere-se ao grau de acesso que o Googlebot tem a todo o seu site. Quanto mais fácil for para o software navegar pelo seu conteúdo, melhor será o seu desempenho dentro dos SERPs.

No entanto, é possível que os crawlers sejam bloqueados, se não do seu site como um todo, certamente de páginas seleccionadas. Problemas comuns que podem afetar negativamente sua capacidade de rastreamento incluem complicações com um DNS, um firewall ou programa de proteção mal configurado, ou às vezes até mesmo o seu sistema de gerenciamento de conteúdo. Deve-se notar que você pode manipular pessoalmente quais páginas o Googlebot pode e não pode ler, mas tome cuidado extra para garantir que suas páginas mais importantes não sejam bloqueadas.

O que posso fazer para otimizar meu site para o Googlebot?

Aqui estão algumas dicas e sugestões em relação à otimização de seu site para o rastreador do Googlebot:

- Seu conteúdo precisa ser facilmente visível em um navegador de texto, portanto não o torne muito complicado. O Googlebot tem dificuldade em rastrear sites que utilizam programas como o Ajax e (às vezes) o JavaScript. Quando em dúvida, mantenha-o simples.

- Utilize páginas canônicas para ajudar o Googlebot a encontrar a versão certa de páginas duplicadas. Para muitos sites é comum ter várias URLs para a mesma página. O Googlebot moderno é até mesmo capaz de saber quando isso está acontecendo, mas ter toneladas de páginas duplicadas em várias URLs pode às vezes confundi-lo, diminuir sua velocidade de indexação e reduzir seu orçamento de rastreamento. É por isso que canonicalizar é a melhor prática para SEO na maioria dos casos.

- Guia o Googlebot pelo seu site usando o seu arquivo robots.txt ou tags meta robots. Bloquear o rastreador de páginas sem importância fará com que o software gaste seu tempo com o seu conteúdo mais valioso e o ajudará a entender a estrutura do seu site. (Nos últimos anos, o Google tem diminuído o efeito do robots.txt para bloquear páginas do índice que não funciona mais para certos, a melhor prática é usar diretivas “sem índice” em vez disso)

- Fresh Content. O Google adora conteúdo fresco e relevante. Actualizar páginas antigas ou criar novas irá despertar o interesse do rastreador. Quanto mais frequentemente você for rastreado, mais chances você terá de aumentar o desempenho. No entanto, isto só se aplica desde que você faça atualizações de qualidade. Certifique-se sempre de que a sua cópia está bem escrita e que não está sobrecarregada com palavras-chave. Conteúdo mal escrito terá apenas um efeito negativo.

- Internal Linking. Links internos por meio de links de texto ancorados, ou ATLs, ajudam a direcionar o crawler através do seu site. Um sistema de links bem consolidado pode tornar o crawl do Googlebot muito mais eficaz. Você quer ser deliberado ao escrever as ATLs. Apenas faça links para páginas relevantes para o seu conteúdo ou produto e certifique-se de que o destino não pode ser acessado de outra forma a partir da barra de navegação da página atual.

- Submeter um mapa do site. Sitemaps são arquivos hospedados no servidor de um site que listam todas as URLs do site (ou todas as URLs que os proprietários do site escolhem incluir pelo menos). Sitemaps são bons para SEO uma vez que dão ao Googlebot uma lista fácil de encontrar e fácil de digerir de todas as suas páginas mais valiosas. Com um sitemap, os sites provavelmente serão indexados mais rapidamente e com mais frequência.

O desempenho do seu site dentro do Google é uma coisa com muitas camadas, e é importante lembrar que o Googlebot está sempre rastreando.

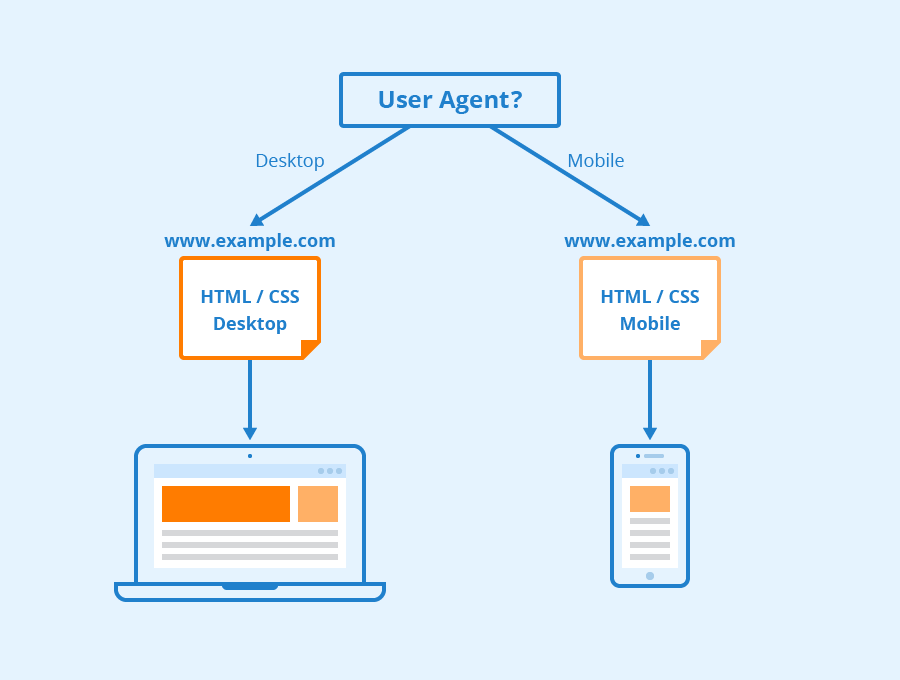

Os diferentes tipos de Googlebots

De acordo com o Google, todos os sites provavelmente serão rastreados tanto pelo Googlebot Desktop quanto pelo Googlebot Smartphone. Variações em seus rastreadores que são projetados para coletar diferentes informações para diferentes dispositivos. Quando o Google anunciou a primeira indexação móvel para seu índice em 2018, isso significava que os sites com versões móveis teriam essa versão inserida em seu índice por padrão – sinalizando para empresas on-line e sites que o tráfego móvel estava se tornando cada vez mais dominante.

Googlebot usa diferentes “user-agents” para imitar diferentes dispositivos ou tecnologias para poder ver como o conteúdo web aparece a esses diferentes softwares.

Via Seobility

O que é o Googlebot Smartphone? Na verdade, quantos Googlebots existem?

Google tem dezesseis bots diferentes concebidos para várias formas de renderização e rastejamento de sites. A verdade é que para SEO você raramente precisa configurar o seu site de forma diferente para qualquer uma delas. Cada um desses bots pode ser tratado de forma diferente usando seu arquivo robots.txt ou seus meta comandos, mas a menos que você especifique diretrizes para um bot em particular, todos eles serão tratados da mesma forma.

Googlebot roda no mecanismo de renderização Chromium do Google, que é atualizado de tempos em tempos para garantir que ele seja capaz de entender os parâmetros e estilos de codificação de sites modernos e para garantir que ele possa rapidamente renderizar páginas modernas.

Googlebot’s Chromium tornou-se o que o google chama de um motor “evergreen”, o que significa que ele sempre executará o mais recente motor baseado no Chromium para renderizar sites da maneira que o navegador Chrome faz (juntamente com outros agentes de usuário para vários outros navegadores web comuns). O objectivo de longa data do Google é ser capaz de renderizar e compreender websites e páginas web da mesma forma que os humanos o fazem, isto significa que o Googlebot irá compreender as páginas da mesma forma que elas aparecem nos browsers web modernos.

Aprenda Mais

O que é o Googlebot em SEO? Contacte-nos para obter mais informações.

Na Radd Interactive, a nossa equipa de analistas trabalha para realizar optimizações estratégicas que melhorem o desempenho de um site como um todo, mantendo em consideração o apetite do Googlebot por conteúdo fresco, relevante e fácil de digerir.

Optimizar o crawler do Googlebot ajuda a garantir que o seu site está a ser rastreado e indexado de forma completa e eficiente para os melhores resultados possíveis.