Ce este Googlebot? – Getting to Know Google’s Crawler

Google crawling și indexare sunt termeni pe care probabil i-ați auzit în timp ce vă scufundați în apele profund dinamice ale optimizării pentru motoarele de căutare. De asemenea, ați auzit probabil despre roboții motorului de căutare Google, cum ar fi celebrul Googlebot.

Dar ce este Googlebot? Și cum funcționează Googlebot în SEO?

Pentru echipa de analiști de la Radd, indexul Google este sângele nostru viu și același lucru este valabil și pentru instituțiile de marketing pe internet din întreaga lume. Este fundația pe care se bazează eforturile noastre. Acestea fiind spuse, vom analiza mai în profunzime aspectele tehnice ale procesului de indexare Google și vom explora modurile în care acesta afectează succesul afacerilor și al site-urilor web.

Pentru afacerile care doresc să își extindă performanțele de căutare și să își crească prezența online, înțelegerea modului în care funcționează Googlebot poate fi de ajutor.

Ce este Googlebot crawling și indexare și cum îmi afectează site-ul?

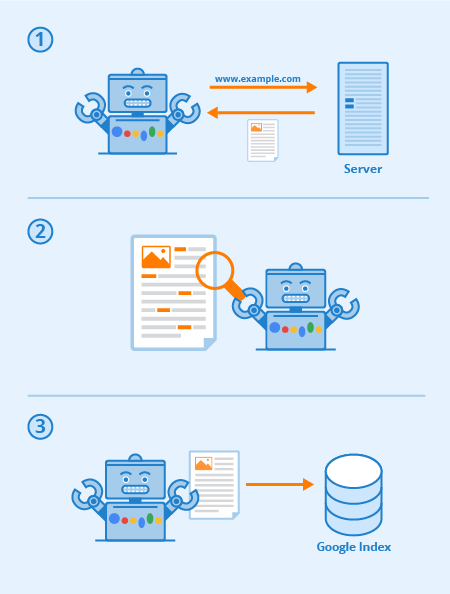

Googlebot este un software special, denumit în mod obișnuit “spider”, conceput pentru a-și croi drum prin paginile site-urilor web publice. Acesta urmărește o serie de linkuri care pornesc de la o pagină la alta, iar apoi procesează datele pe care le găsește într-un index colectiv.

Acest software permite Google să compileze peste 1 milion de GB de informații în doar o fracțiune de secundă. Rezultatele căutărilor online sunt apoi extrase direct din acest index. Un mod amuzant și ușor de a ne gândi la el este ca la o bibliotecă cu un inventar în continuă expansiune. Googlebot este un termen generic pentru instrumentele pe care le folosește pentru a descoperi conținutul web atât în setările desktop, cât și în cele mobile.

Din acest punct de vedere, atunci ce este Googlebot în termeni SEO?

Optimizarea strategică a paginilor web funcționează pentru a crește vizibilitatea printre rezultatele căutărilor web. Modul în care este cartografiat site-ul dvs. web prin intermediul legăturilor de text poate spori foarte mult eficiența generală a răsfoirii de către Googlebot. Practicile SEO substanțiale includ tehnici de optimizare orientate atât către Googlebot, cât și către paginile de rezultate ale motoarelor de căutare (SERPs).

În ultimă instanță, cu cât este mai clară și mai concisă harta site-ului dvs. și conținutul, cu atât mai proeminente vor fi paginile dvs. în general.

Toate motoarele de căutare (și multe alte site-uri web) au roboți, iar Googlebot este cel al Google. Googlebot este un robot de crawling care, în termeni simpli, merge din link în link încercând să descopere noi URL-uri pentru indexul său.

Iată cum funcționează Googlebot: link-urile sunt esențiale pentru a-i permite să treacă de la o pagină la alta (și pot fi, de asemenea, orice tip de link) – link-uri de imagine, nav-bar, anchor-text și chiar link-uri ascunse cu JavaScript lizibil în mod corespunzător.

Când aceste pagini sunt descoperite, conținutul lor este redat de Googlebot și conținutul său este citit pentru ca motorul de căutare să poată determina subiectul, precum și valoarea sa pentru cei care fac căutări. O strategie SEO adecvată înseamnă că site-urile cu o structură bună, timpi de încărcare rapizi și un conținut ușor de înțeles sunt ușor de digerat de Googlebot și pot ajuta la SEO-ul unui site.

Viabilitatea site-ului

Ce este crawlabilitatea site-ului?

Crawlabilitatea se referă la gradul de acces pe care Googlebot îl are la întregul dumneavoastră site. Cu cât este mai ușor pentru software să treacă prin conținutul dvs., cu atât mai bună va fi performanța dvs. în cadrul SERPs.

Cu toate acestea, este posibil ca crawlerele să fie blocate, dacă nu de site-ul dvs. ca întreg, cu siguranță de anumite pagini. Problemele obișnuite care pot afecta în mod negativ crawlabilitatea dvs. includ complicații cu un DNS, un firewall sau un program de protecție configurat greșit sau, uneori, chiar sistemul dvs. de gestionare a conținutului. Trebuie remarcat faptul că puteți manipula personal ce pagini poate și ce pagini nu poate citi Googlebot, dar aveți grijă sporită să vă asigurați că cele mai importante pagini ale dvs. nu sunt blocate.

Ce pot face pentru a-mi optimiza site-ul pentru Googlebot?

Iată câteva sfaturi și sugestii în ceea ce privește optimizarea site-ului dvs. pentru crawlerul Googlebot:

- Conținutul dvs. trebuie să fie ușor vizibil într-un browser de text, așa că nu-l faceți prea complicat. Googlebot întâmpină dificultăți în parcurgerea site-urilor care utilizează programe precum Ajax și (uneori) JavaScript. Atunci când aveți îndoieli, păstrați-l simplu.

- Utilizați pagini canonice pentru a ajuta Googlebot să găsească versiunea corectă a paginilor duplicate. Pentru multe site-uri web este obișnuit să aveți mai multe URL-uri pentru aceeași pagină. Googlebotul modern este chiar capabil să știe când se întâmplă acest lucru, dar faptul de a avea tone de pagini duplicate pe mai multe URL-uri îl poate confunda uneori, îi încetinește viteza de indexare și vă reduce bugetul de căutare. De aceea, canonicalizarea este cea mai bună practică pentru SEO în majoritatea cazurilor.

- Călăuziți Googlebot prin site-ul dvs. folosind fișierul robots.txt sau tag-urile meta robots. Blocarea crawlerului de la paginile neimportante va face ca software-ul să își petreacă timpul pe conținutul dvs. mai valoros și îl va ajuta să înțeleagă structura site-ului dvs. (În ultimii ani, Google a diminuat efectul robots.txt pentru blocarea paginilor din index, care nu mai funcționează în mod cert, cea mai bună practică este să folosiți în schimb directivele “no-index”)

- Contenit proaspăt. Google iubește conținutul proaspăt și relevant. Actualizarea paginilor vechi sau crearea unor pagini noi va stârni interesul crawlerului. Cu cât sunteți cercetat mai frecvent, cu atât aveți mai multe șanse de a crește performanța. Totuși, acest lucru este valabil doar atât timp cât faceți actualizări de calitate. Asigurați-vă întotdeauna că textul dvs. este bine scris și nu este supraîncărcat cu cuvinte cheie. Conținutul prost scris va avea doar un efect negativ.

- Legături interne. Legăturile interne prin intermediul legăturilor cu text de ancorare, sau ATL-uri, ajută la direcționarea crawlerului prin site-ul dumneavoastră. Un sistem de legături bine consolidat poate face mult mai eficientă parcurgerea de către Googlebot. Trebuie să fiți deliberat atunci când scrieți ATL-uri. Creați linkuri numai către pagini care sunt relevante pentru conținutul sau produsul dvs. și asigurați-vă că destinația nu poate fi accesată altfel din bara de navigare a paginii curente.

- Submiterea unei hărți a site-ului. Sitemaps sunt fișiere găzduite pe serverul unui site care listează toate URL-urile site-ului (sau cel puțin toate cele pe care proprietarii site-ului aleg să le includă). Sitemaps sunt bune pentru SEO, deoarece îi oferă lui Googlebot o listă ușor de găsit și ușor de digerat a tuturor paginilor dvs. cele mai valoroase. Cu un sitemap, site-urile vor fi probabil indexate mai repede și mai frecvent.

Performanța site-ului dvs. în cadrul Google este un lucru cu mai multe straturi și este important să vă amintiți că Googlebot este mereu în căutare.

Diferitele tipuri de Googlebots

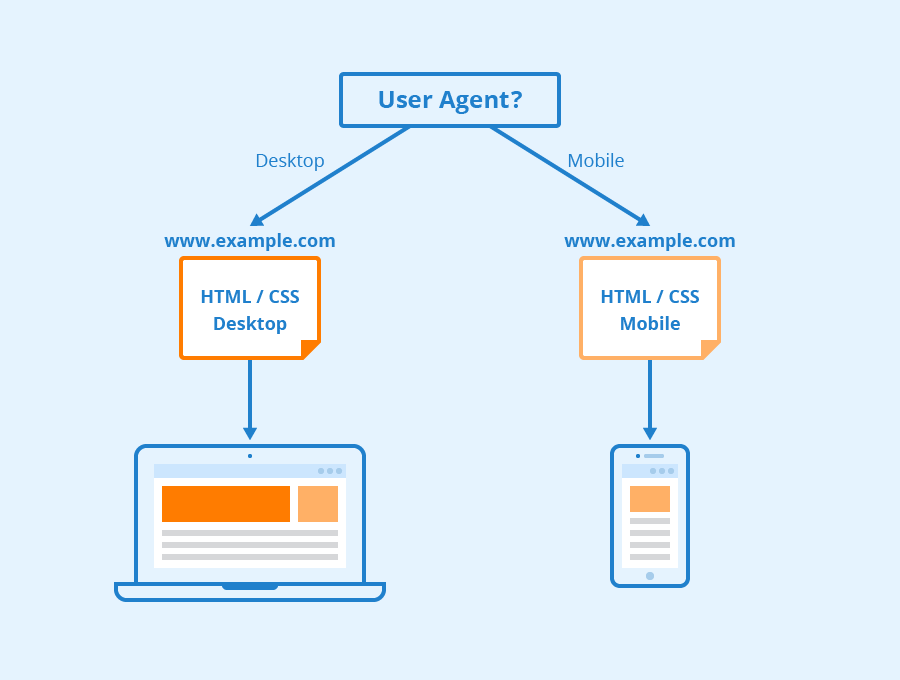

Potrivit Google, toate site-urile vor fi probabil căutate atât de Googlebot Desktop, cât și de Googlebot Smartphone. Variante ale crawlerelor sale care sunt concepute pentru a colecta informații diferite pentru diferite dispozitive. Când Google a anunțat indexarea mobile-first pentru indexul său în 2018, a însemnat că site-urile web cu versiuni mobile vor avea acea versiune introdusă în indexul său în mod implicit – semnalând întreprinderilor și site-urilor web online că traficul mobil devine din ce în ce mai dominant.

Googlebot folosește diferiți “user-agents” pentru a imita diferite dispozitive sau tehnologii, astfel încât să poată vedea cum apare conținutul web la acele softuri diferite.

Via Seobility

Ce este Googlebot Smartphone? De fapt, câți roboți Google există?

Google are șaisprezece roboți diferiți, concepuți pentru diferite forme de redare și crawling a site-urilor. Adevărul este că, pentru SEO, rareori trebuie să vă configurați site-ul în mod diferit pentru oricare dintre acestea. Fiecare dintre acești roboți poate fi gestionat diferit folosind fișierul robots.txt sau comenzile meta, dar, dacă nu specificați directive pentru un anumit robot, toți vor fi tratați în același mod.

Googlebot rulează pe motorul de randare Chromium al Google, care este actualizat din când în când pentru a se asigura că este capabil să înțeleagă parametrii și stilurile moderne de codificare a site-urilor web și pentru a se asigura că poate reda rapid paginile moderne.

Procesorul Chromium al lui Google a devenit ceea ce Google numește un motor “evergreen”, ceea ce înseamnă că va rula întotdeauna cel mai recent motor bazat pe Chromium pentru redarea site-urilor web în modul în care o face browserul Chrome (împreună cu alți agenți de utilizator pentru diverse alte browsere web obișnuite). Obiectivul de lungă durată al Google este de a fi capabil să redea și să înțeleagă site-urile și paginile web în același mod în care o fac oamenii, ceea ce înseamnă că Googlebot va înțelege paginile cam în același mod în care acestea apar în browserele web moderne.

Învățați mai multe

Acum ce este Googlebot în SEO? Contactați-ne pentru a obține mai multe informații.

La Radd Interactive, echipa noastră de analiști lucrează pentru a efectua optimizări strategice care îmbunătățesc performanța unui site ca întreg, ținând cont de apetitul lui Googlebot pentru conținut proaspăt, relevant și ușor de digerat.

Optimizarea pentru crawlerul Googlebot ajută la asigurarea faptului că site-ul dvs. este răscolit și indexat atât temeinic, cât și eficient pentru cele mai bune rezultate posibile.