Hvad er Googlebot? – Lær Google’s Crawler at kende

Google crawling og indeksering er udtryk, du sikkert har hørt, mens du dykker ned i søgemaskineoptimeringens dybt dynamiske farvande. Du har sikkert også hørt om Googles søgemaskinerobotter som den berømte Googlebot.

Men hvad er Googlebot? Og hvordan fungerer Googlebot i SEO?

For analytikerteamet hos Radd er Googles indeks vores livsnerve, og det samme gælder for internetmarkedsføringsinstitutioner verden over. Det er det fundament, som vores indsats er bygget på. Når det er sagt, vil vi tage et dybere kig på de tekniske detaljer i Googles indekseringsproces og udforske de måder, hvorpå det påvirker virksomheder og websites succes.

For virksomheder, der ønsker at udvide deres søgepræstationer og vokse deres online tilstedeværelse, kan det være en hjælp at forstå, hvordan Googlebot fungerer.

Hvad er Googlebot crawling og indeksering, og hvordan påvirker det mit websted?

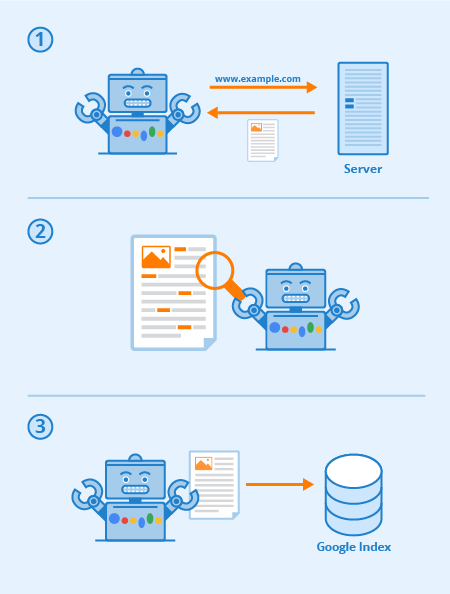

Googlebot er en særlig software, der almindeligvis kaldes en spider, og som er designet til at kravle sig vej gennem siderne på offentlige websteder. Den følger en række links fra den ene side til den anden og bearbejder derefter de data, den finder, til et samlet indeks.

Denne software gør det muligt for Google at samle over 1 million GB oplysninger på kun en brøkdel af et sekund. Online-søgeresultaterne trækkes derefter direkte fra dette indeks. En sjov og nem måde at tænke på det på er som et bibliotek med et stadigt voksende inventar. Googlebot er en fællesbetegnelse for de værktøjer, den bruger til at finde webindhold i både desktop- og mobilindstillinger.

Med dette i baghovedet, hvad er Googlebot så i SEO-termer?

Den strategiske optimering af websider arbejder for at øge synligheden blandt websøgeresultaterne. Den måde, hvorpå dit websted er kortlagt via tekstlinks, kan i høj grad øge den samlede effektivitet af Googlebots crawl. Væsentlige SEO-praksisser omfatter optimeringsteknikker, der er rettet mod både Googlebot og søgemaskinernes resultatsider (SERP’er).

I sidste ende er det sådan, at jo mere klart og præcist dit sitemap og indhold er, jo mere fremtrædende vil dine sider sandsynligvis være samlet set.

Alle søgemaskiner (og mange andre websites) har bots, og Googlebot er Googles. Googlebot er en crawling-bot, der i enkle vendinger går fra link til link og forsøger at finde nye URL’er til sit indeks.

Sådan fungerer Googlebot: Links er afgørende for, at den kan gå fra side til side (og de kan også være alle slags links) – billedlinks, nav-bar, anker-tekst og endda links skjult med korrekt læsbar JavaScript.

Når disse sider opdages, gengives deres indhold af Googlebot, og deres indhold læses, så søgemaskinen kan bestemme deres emne samt deres værdi for søgende. En korrekt SEO-strategi betyder, at websteder med god struktur, hurtige indlæsningstider og forståeligt indhold er lette at fordøje for Googlebot og kan hjælpe et websted med hensyn til SEO.

Via Seobility

Hvad er crawlability på et websted?

Crawlability refererer til graden af adgang, som Googlebot har til hele dit websted. Jo lettere det er for softwaren at gennemgå dit indhold, jo bedre vil din præstation i SERP’erne være.

Det er dog muligt for crawlere at blive blokeret, om ikke fra dit websted som helhed, så i hvert fald fra udvalgte sider. Almindelige problemer, der kan påvirke din crawlability negativt, omfatter komplikationer med en DNS, en fejlkonfigureret firewall eller et beskyttelsesprogram, eller nogle gange endda dit indholdsstyringssystem. Det skal bemærkes, at du selv kan manipulere med, hvilke sider Googlebot kan og ikke kan læse, men vær ekstra omhyggelig med at sikre, at dine vigtigste sider ikke bliver blokeret.

Hvad kan jeg gøre for at optimere mit websted for Googlebot?

Her er et par tips og forslag med hensyn til at optimere dit websted for Googlebot-crawleren:

- Dit indhold skal være let synligt i en tekstbrowser, så lad være med at gøre det for kompliceret. Googlebot har svært ved at crawle websteder, der anvender programmer som Ajax og (nogle gange) JavaScript. Når du er i tvivl, skal du holde det simpelt.

- Brug kanoniske sider for at hjælpe Googlebot med at finde den rigtige version af duplikerede sider. For mange websteder er det almindeligt at have flere URL’er for den samme side. Moderne Googlebot er endda i stand til at vide, hvornår dette sker, men at have tonsvis af duplikerede sider på tværs af flere URL’er kan nogle gange forvirre den, sænke dens indekseringshastighed og reducere dit crawlbudget. Derfor er kanonisering i de fleste tilfælde den bedste praksis for SEO.

- Guide Googlebot gennem dit websted ved hjælp af din robots.txt-fil eller meta robots-tags. Hvis du blokerer crawleren for uvæsentlige sider, får du softwaren til at bruge sin tid på dit mere værdifulde indhold og hjælper den med at forstå strukturen på dit websted. (I de seneste år har Google nedtonet effekten af robots.txt til at blokere sider fra indekset, hvilket ikke længere virker for visse, bedste praksis er at bruge “no-index”-direktiver i stedet)

- Frisk indhold. Google elsker frisk og relevant indhold. Opdatering af gamle sider eller oprettelse af nye sider vil vække crawlerens interesse. Jo hyppigere du bliver crawlet, jo flere chancer har du for at øge ydeevnen. Dette gælder dog kun, så længe du laver kvalitetsopdateringer. Sørg altid for, at din tekst er velskrevet og ikke overfyldt med søgeord. Dårligt skrevet indhold vil kun have en negativ effekt.

- Internal Linking. Intern linking ved hjælp af ankertekstlinks eller ATL’er hjælper med at lede crawleren gennem dit websted. Et tæt konsolideret linking-system kan gøre Googlebot’s crawl meget mere effektiv. Du skal være velovervejet, når du skriver ATL’er. Link kun til sider, der er relevante for dit indhold eller produkt, og sørg for, at destinationen ellers ikke kan tilgås fra den aktuelle sides navigationslinje.

- Indsendelse af et sitemap. Sitemaps er filer, der er hostet på et webstedets server, og som indeholder en liste over alle webstedets URL’er (eller i det mindste alle de URL’er, som webstedets ejere vælger at medtage). Sitemaps er gode for SEO, da de giver Googlebot en let at finde og let at fordøje en liste over alle dine mest værdifulde sider. Med et sitemap vil websteder sandsynligvis blive indekseret hurtigere og hyppigere.

Din websteds præstation i Google er en mangesidet ting, og det er vigtigt at huske, at Googlebot altid crawler.

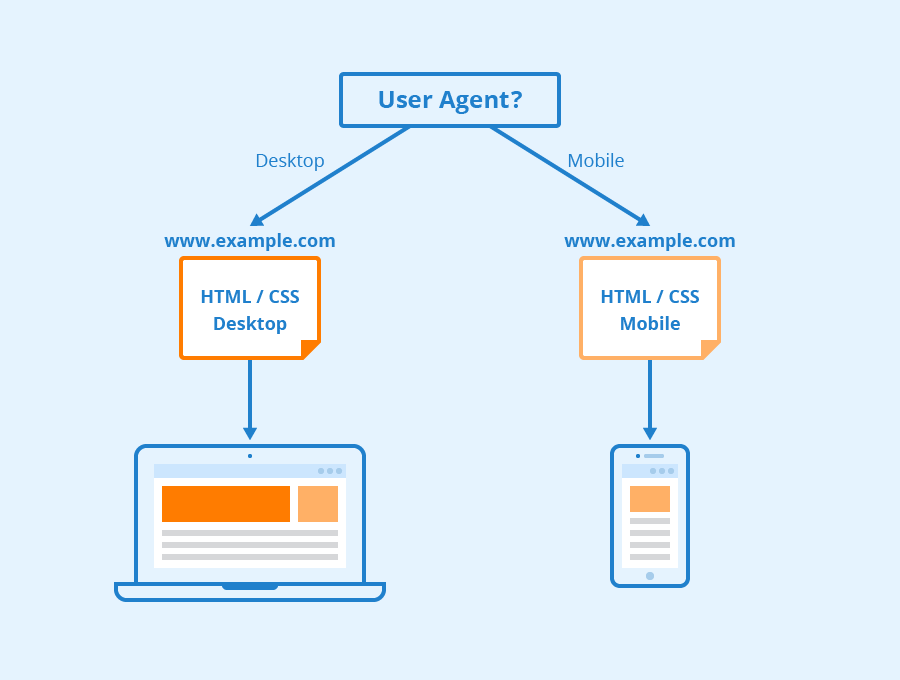

De forskellige slags Googlebots

I henhold til Google vil alle websteder sandsynligvis blive crawlet af både Googlebot Desktop og Googlebot Smartphone. Variationer på sine crawlere, der er designet til at indsamle forskellige oplysninger til forskellige enheder. Da Google annoncerede mobile-first-indeksering for sit indeks i 2018, betød det, at websites med mobilversioner som standard ville få den version optaget i indekset – et signal til onlinevirksomheder og websites om, at mobiltrafikken blev stadig mere dominerende.

Googlebot bruger forskellige “user-agents” til at efterligne forskellige enheder eller teknologier, så den kan se, hvordan webindholdet ser ud for disse forskellige softwares.

Via Seobility

Hvad er Googlebot Smartphone? Hvor mange Googlebots er der egentlig?

Google har seksten forskellige bots, der er designet til forskellige former for rendering og crawling af websteder. Sandheden er, at for SEO har du sjældent nogensinde brug for at opsætte dit websted anderledes for nogen af disse. Hver af disse bots kan håndteres forskelligt ved hjælp af din robots.txt-fil eller dine metakommandoer, men medmindre du angiver direktiver for en bestemt bot, vil de alle blive behandlet på samme måde.

Googlebot kører på Googles Chromium-renderingsmotor, som opdateres fra tid til anden for at sikre, at den er i stand til at forstå moderne hjemmesidekodningsparametre og -stilarter og for at sikre, at den hurtigt kan gengive moderne sider.

Googlebots Chromium er blevet det, som Google kalder en “evergreen”-motor, hvilket betyder, at den altid vil køre den nyeste Chromium-baserede motor til rendering af websteder på den måde, som Chrome-browseren gør (sammen med andre brugeragenter til forskellige andre almindelige webbrowsere). Googles mangeårige mål er at kunne gengive og forstå websteder og websider på samme måde som mennesker gør, hvilket betyder, at Googlebot vil forstå sider på stort set samme måde, som de vises i moderne webbrowsere.

Lær mere

Så hvad er Googlebot i SEO? Kontakt os for at få mere information.

Hos Radd Interactive arbejder vores analyste-team på at udføre strategiske optimeringer, der forbedrer et websteds ydeevne som helhed, og som tager hensyn til Googlebots appetit på frisk, relevant og letfordøjeligt indhold.

Optimering til Googlebot crawleren hjælper med at sikre, at dit websted bliver crawlet og indekseret både grundigt og effektivt for at opnå de bedst mulige resultater.