Vad är Googlebot? – Lär känna Googles crawler

Google crawling och indexering är termer som du förmodligen har hört när du dykt ner i sökmotoroptimeringens djupt dynamiska vatten. Du har förmodligen också hört talas om Googles sökmotorrobotar som den berömda Googlebot.

Men vad är Googlebot? Och hur fungerar Googlebot inom SEO?

För analysteamet på Radd är Googles index vårt livsnerv, och detsamma gäller för internetmarknadsföringsinstitutioner världen över. Det är den grund som våra insatser bygger på. Med detta sagt kommer vi att ta en djupare titt på teknikaliteterna i Googles indexeringsprocess och utforska hur den påverkar företagens och webbplatsernas framgång.

För företag som vill utöka sin sökprestanda och öka sin närvaro på nätet kan det vara till hjälp att förstå hur Googlebot fungerar.

Vad är Googlebot crawling och indexering och hur påverkar det min webbplats?

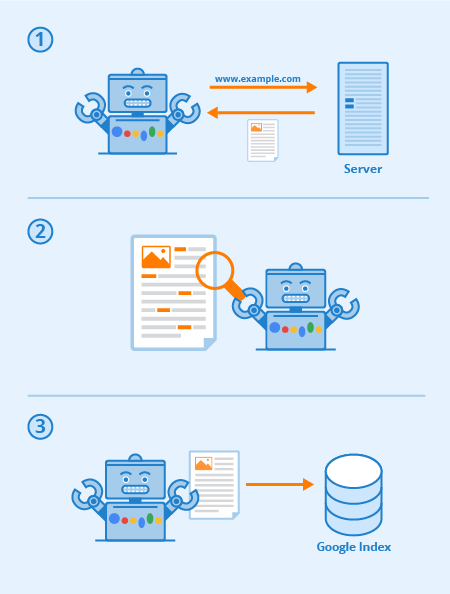

Googlebot är en speciell programvara, vanligen kallad spindel, som är utformad för att krypa sig fram genom sidorna på offentliga webbplatser. Den följer en serie länkar som börjar från en sida till nästa och bearbetar sedan de uppgifter den hittar till ett kollektivt index.

Denna programvara gör det möjligt för Google att sammanställa över 1 miljon GB information på bara en bråkdel av en sekund. Sökresultaten på nätet hämtas sedan direkt från detta index. Ett roligt och enkelt sätt att tänka på det är som ett bibliotek med ett ständigt växande bestånd. Googlebot är en allmän term för de verktyg som den använder för att upptäcka webbinnehåll i både skrivbords- och mobilinställningar.

Med detta i åtanke, vad är då Googlebot i SEO-termer?

Den strategiska optimeringen av webbsidor arbetar för att öka synligheten bland sökresultaten på webben. Det sätt på vilket din webbplats kartläggs via textlänkar kan i hög grad öka den övergripande effektiviteten av Googlebots crawlning. Väsentliga SEO-metoder omfattar optimeringstekniker som är inriktade på både Googlebot och sökmotorns resultatsidor (SERP).

I slutändan gäller att ju tydligare och kortfattadare din webbplatskarta och ditt innehåll är, desto mer framträdande kommer dina sidor troligen att vara överlag.

Varje sökmotor (och många andra webbplatser) har bots, och Googlebot är Googles. Googlebot är en robot som går från länk till länk och försöker hitta nya webbadresser för sitt index.

Så här arbetar Googlebot: Länkar är viktiga för att Googlebot ska kunna gå från sida till sida (och det kan vara vilken typ av länk som helst) – bildlänkar, nav-bar, ankartext och till och med länkar som döljs med korrekt läsbar JavaScript.

När dessa sidor upptäcks återges deras innehåll av Googlebot och dess innehåll läses så att sökmotorn kan avgöra dess ämne samt dess värde för sökare. En korrekt SEO-strategi innebär att webbplatser med bra struktur, snabba laddningstider och begripligt innehåll är lätta för Googlebot att smälta och kan bidra till en webbplats SEO.

Via Seobility

Vad är krypbarhet på en webbplats?

Krypbarhet avser graden av åtkomst som Googlebot har till hela din webbplats. Ju lättare det är för programvaran att gå igenom ditt innehåll, desto bättre blir ditt resultat i SERP.

Det är dock möjligt för crawlers att blockeras, om inte från din webbplats som helhet, så i alla fall från utvalda sidor. Vanliga problem som kan påverka din crawlability negativt är komplikationer med en DNS, en felkonfigurerad brandvägg eller ett skyddsprogram, eller ibland till och med ditt innehållshanteringssystem. Det bör noteras att du personligen kan manipulera vilka sidor Googlebot kan och inte kan läsa, men var extra noga med att se till att dina viktigaste sidor inte blockeras.

Vad kan jag göra för att optimera min webbplats för Googlebot?

Här är några tips och förslag när det gäller att optimera din webbplats för Googlebot crawler:

- Ditt innehåll måste vara lätt synligt i en textwebbläsare, så gör det inte för komplicerat. Googlebot har svårt att crawla webbplatser som använder program som Ajax och (ibland) JavaScript. Om du är osäker, håll det enkelt.

- Använd kanoniska sidor för att hjälpa Googlebot att hitta rätt version av dubbla sidor. För många webbplatser är det vanligt att ha flera webbadresser för samma sida. Den moderna Googlebot kan till och med veta när detta sker, men att ha massor av dubbla sidor på flera URL:er kan ibland förvirra den, sänka dess indexeringshastighet och minska din crawlbudget. Därför är kanonisering i de flesta fall bästa praxis för SEO.

- Guide Googlebot genom din webbplats med hjälp av din robots.txt-fil eller meta robots-taggar. Om du blockerar crawlern från oviktiga sidor får programvaran att spendera sin tid på ditt mer värdefulla innehåll och hjälper den att förstå webbplatsens struktur. (På senare år har Google tonat ner effekten av robots.txt för att blockera sidor från indexet vilket inte längre fungerar för vissa, bästa praxis är att använda “no-index”-direktiv istället)

- Färskt innehåll. Google älskar färskt och relevant innehåll. Att uppdatera gamla sidor eller skapa nya sidor väcker crawlerns intresse. Ju oftare du blir crawlad, desto större chanser har du att öka prestandan. Detta gäller dock bara så länge du gör kvalitetsuppdateringar. Se alltid till att dina texter är välskrivna och inte överfyllda med nyckelord. Dåligt skrivet innehåll kommer bara att ha en negativ effekt.

- Intern länkning. Intern länkning med hjälp av ankartextlänkar eller ATL-länkar hjälper till att styra crawlern genom din webbplats. Ett tätt konsoliderat länksystem kan göra Googlebot’s crawl mycket effektivare. Du bör vara medveten när du skriver ATL:er. Länka endast till sidor som är relevanta för ditt innehåll eller din produkt, och se till att destinationen annars inte kan nås från den aktuella sidans navigeringsfält.

- Sända in en sitemap. Sitemaps är filer som finns på en webbplats server och som innehåller en förteckning över webbplatsens alla webbadresser (eller åtminstone alla de webbadresser som webbplatsägarna väljer att inkludera). Sitemaps är bra för SEO eftersom de ger Googlebot en lätt att hitta och lätt att smälta lista över alla dina mest värdefulla sidor. Med en sitemap kommer webbplatser sannolikt att indexeras snabbare och oftare.

Din webbplatsens prestanda inom Google är en mångfacetterad sak, och det är viktigt att komma ihåg att Googlebot alltid crawlar.

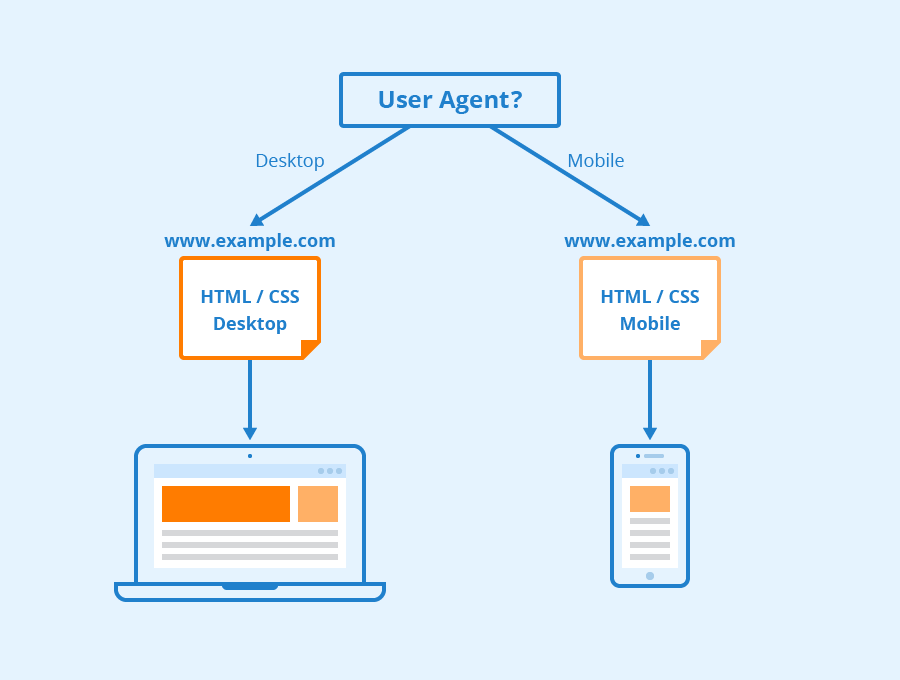

De olika typerna av Googlebots

Enligt Google kommer alla webbplatser sannolikt att crawlas av både Googlebot Desktop och Googlebot Smartphone. Variationer av dess crawlers som är utformade för att samla in olika information för olika enheter. När Google tillkännagav mobil först-indexering för sitt index 2018 innebar det att webbplatser med mobilversioner skulle få den versionen inlagd i indexet som standard – en signal till onlineföretag och webbplatser om att mobiltrafiken blev allt mer dominerande.

Googlebot använder olika “user-agents” för att efterlikna olika enheter eller tekniker så att den kan se hur webbinnehållet ser ut för dessa olika programvaror.

Via Seobility

Vad är Googlebot Smartphone? Hur många Googlebots finns det egentligen?

Google har sexton olika bots som är utformade för olika former av rendering och crawling av webbplatser. Sanningen är att för SEO behöver du sällan någonsin konfigurera din webbplats annorlunda för någon av dessa. Var och en av dessa robotar kan hanteras på olika sätt med hjälp av din robots.txt-fil eller dina metakommandon, men om du inte anger direktiv för en viss robot kommer alla att behandlas på samma sätt.

Googlebot körs på Googles renderingsmotor Chromium som uppdateras från tid till annan för att se till att den kan förstå moderna kodningsparametrar och stilar för webbplatser och för att se till att den snabbt kan rendera moderna sidor.

Googlebots Chromium har blivit vad Google kallar en “evergreen”-motor vilket innebär att den alltid kommer att köra den senaste Chromium-baserade motorn för rendering av webbplatser på samma sätt som webbläsaren Chrome gör (tillsammans med andra användaragenter för olika andra vanliga webbläsare). Googles långsiktiga mål är att kunna återge och förstå webbplatser och webbsidor på samma sätt som människor gör, vilket innebär att Googlebot kommer att förstå sidor på samma sätt som de visas i moderna webbläsare.

Lär dig mer

Så vad är Googlebot i SEO? Kontakta oss för att få mer information.

På Radd Interactive arbetar vårt analysteam för att utföra strategiska optimeringar som förbättrar webbplatsens prestanda som helhet, med hänsyn till Googlebots aptit för färskt, relevant och lättsmält innehåll.

Optimering för Googlebots crawler hjälper till att se till att din webbplats crawlas och indexeras både grundligt och effektivt för att få bästa möjliga resultat.