Wat is Googlebot? – Google’s Crawler leren kennen

Google crawling en indexing zijn termen die u waarschijnlijk hebt gehoord terwijl u in de diep dynamische wateren van zoekmachine optimalisatie dook. Je hebt waarschijnlijk ook gehoord over Google’s zoekmachine bots zoals de beroemde Googlebot.

Maar wat is Googlebot? En hoe werkt Googlebot in SEO?

Voor het analistenteam van Radd is de index van Google ons levensbloed, en hetzelfde geldt voor internetmarketinginstellingen wereldwijd. Het is het fundament waarop onze inspanningen zijn gebouwd. Met dat gezegd hebbende, gaan we dieper in op de technische details van Google’s indexeringsproces en onderzoeken we de manieren waarop het van invloed is op het succes van bedrijven en websites.

Voor bedrijven die hun zoekprestaties willen uitbreiden en hun online aanwezigheid willen laten groeien, kan het helpen om te begrijpen hoe Googlebot werkt.

Wat is Googlebot crawlen en indexeren, en hoe beïnvloedt het mijn site?

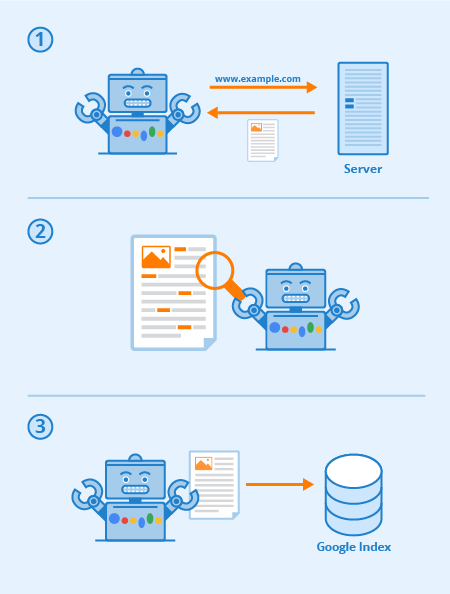

Googlebot is een speciale software, meestal aangeduid als een spider, ontworpen om zijn weg te kruipen door de pagina’s van openbare websites. Het volgt een reeks links, beginnend van de ene pagina naar de volgende, en verwerkt vervolgens de gegevens die het vindt in een collectieve index.

Deze software stelt Google in staat om meer dan 1 miljoen GB aan informatie te verzamelen in slechts een fractie van een seconde. Online zoekresultaten worden dan rechtstreeks uit deze index gehaald. Een leuke en makkelijke manier om het te zien is als een bibliotheek met een steeds groter wordende inventaris. Googlebot is een algemene term voor de tools die het gebruikt om web-inhoud te ontdekken in zowel desktop-en mobiele instellingen.

Met dit in gedachten, wat is Googlebot in SEO termen?

De strategische optimalisatie van webpagina’s werkt om de zichtbaarheid te verhogen onder de web zoekresultaten. De manier waarop uw website in kaart is gebracht via tekstlinks kan de algehele effectiviteit van het crawlen door Googlebot sterk verbeteren. Substantiële SEO-praktijken omvatten optimalisatietechnieken die zijn gericht op zowel Googlebot als de pagina’s met zoekmachineresultaten (SERP’s).

Tot slot, hoe duidelijker en beknopter uw sitemap en inhoud is, hoe prominenter uw pagina’s waarschijnlijk over het geheel genomen zullen zijn.

Elke zoekmachine (en veel andere websites) heeft bots, en Googlebot is die van Google. Googlebot is een crawlingbot die simpel gezegd van link naar link gaat en nieuwe URL’s probeert te ontdekken voor zijn index.

Hier ziet u hoe Googlebot werkt: links zijn van cruciaal belang om hem van pagina naar pagina te laten gaan (en het kunnen ook allerlei soorten links zijn) – afbeeldingslinks, navigatiebalk, ankertekst en zelfs links die verborgen zijn met goed leesbare JavaScript.

Wanneer deze pagina’s worden ontdekt, wordt hun inhoud door Googlebot weergegeven en wordt de inhoud gelezen, zodat de zoekmachine het onderwerp kan bepalen, evenals de waarde voor zoekers. Een goede SEO-strategie betekent dat sites met een goede structuur, snelle laadtijden en begrijpelijke inhoud voor Googlebot gemakkelijk te verteren zijn en de SEO van een site kunnen helpen.

Via Seobility

Wat is website crawlability?

Crawlability verwijst naar de mate van toegang die Googlebot tot uw hele site heeft. Hoe gemakkelijker het is voor de software om te ziften door uw inhoud, hoe beter uw prestaties binnen de SERPs zal zijn.

Het is echter mogelijk voor crawlers te worden geblokkeerd, zo niet van uw site als geheel, zeker van selecte pagina’s. Veel voorkomende problemen die een negatieve invloed kunnen hebben op uw crawlability zijn complicaties met een DNS, een verkeerd geconfigureerde firewall of beveiligingsprogramma, of soms zelfs uw content management systeem. Opgemerkt moet worden dat u zelf kunt manipuleren welke pagina’s Googlebot wel en niet kan lezen, maar zorg er extra voor dat uw belangrijkste pagina’s niet worden geblokkeerd.

Wat kan ik doen om mijn site te optimaliseren voor Googlebot?

Hier volgen een paar tips en suggesties met betrekking tot het optimaliseren van uw website voor de Googlebot crawler:

- Uw inhoud moet gemakkelijk zichtbaar zijn in een tekstbrowser, dus maak het niet te ingewikkeld. Googlebot heeft het moeilijk met het crawlen van sites die gebruik maken van programma’s zoals Ajax en (soms) JavaScript. Bij twijfel, houd het simpel.

- Gebruik canonieke pagina’s om Googlebot te helpen de juiste versie van dubbele pagina’s te vinden. Voor veel websites is het gebruikelijk om meerdere URL’s voor dezelfde pagina te hebben. De moderne Googlebot is zelfs in staat om te weten wanneer dit gebeurt, maar het hebben van tonnen dubbele pagina’s over meerdere URL’s kan soms verwarrend zijn, vertraagt de indexering snelheid, en vermindert uw crawl budget. Dat is de reden waarom canonicalizing is best-practice voor SEO in de meeste gevallen.

- Begeleid Googlebot door uw site met behulp van uw robots.txt bestand of meta robots tags. Als u de crawler blokkeert voor onbelangrijke pagina’s, besteedt de software meer tijd aan uw waardevolle inhoud en begrijpt hij de structuur van uw site beter. (In de afgelopen jaren Google heeft gebagatelliseerd het effect van robots.txt voor het blokkeren van pagina’s uit de index die niet meer werkt voor bepaalde, beste praktijk is om “no-index” directives te gebruiken in plaats daarvan)

- Verse inhoud. Google houdt van verse en relevante inhoud. Het bijwerken van oude pagina’s of het creëren van nieuwe pagina’s zal de crawler’s interesse te wekken. Hoe vaker u wordt gecrawld, hoe meer kans u hebt om uw prestaties te verbeteren. Dit geldt echter alleen zolang u kwaliteitsupdates maakt. Zorg er altijd voor dat uw teksten goed geschreven zijn en niet overladen zijn met trefwoorden. Slecht geschreven content zal alleen maar een negatief effect hebben.

- Internal Linking. Intern linken door middel van ankertekst links, of ATL’s, helpt de crawler leiden door uw site. Een strak geconsolideerd linking systeem kan Googlebot’s crawl veel effectiever maken. U moet weloverwogen zijn bij het schrijven van ATL’s. Link alleen naar pagina’s die relevant zijn voor uw inhoud of product, en zorg ervoor dat de bestemming niet anders kan worden bereikt vanuit de navigatiebalk van de huidige pagina.

- Het indienen van een sitemap. Sitemaps zijn bestanden die worden gehost op de server van een site die een lijst van alle URL’s van de site (of alle van de site-eigenaren ervoor kiezen om op zijn minst op te nemen). Sitemaps zijn goed voor SEO omdat ze Googlebot een makkelijk te vinden en makkelijk te verteren lijst geven van al je meest waardevolle pagina’s. Met een sitemap, zal sites waarschijnlijk sneller en vaker geïndexeerd.

De prestaties van uw site binnen Google is een veel gelaagde ding, en het is belangrijk om te onthouden dat Googlebot is altijd crawling.

De verschillende soorten Googlebots

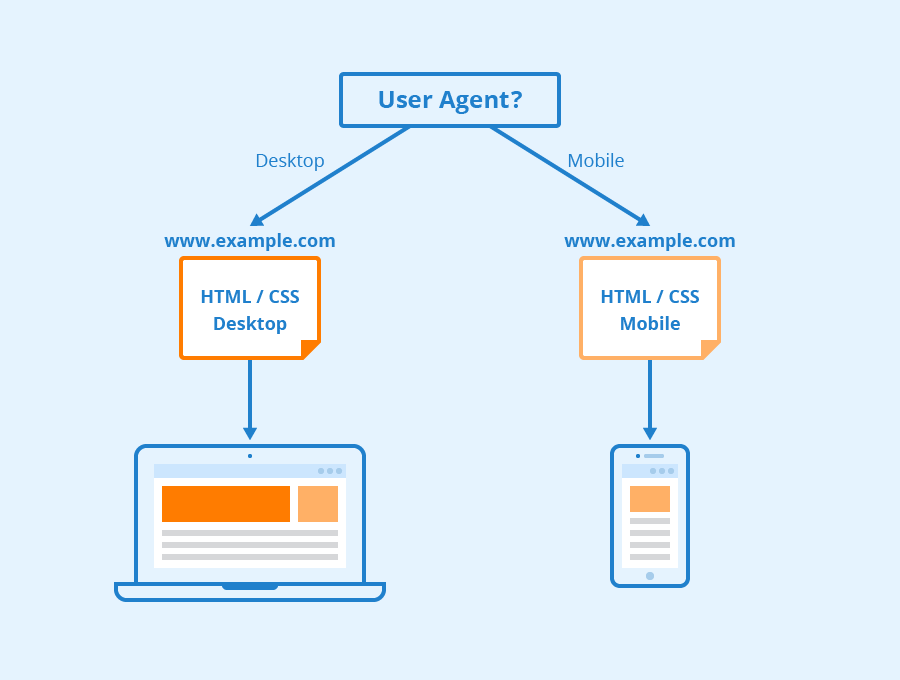

Volgens Google alle websites zijn waarschijnlijk gaat worden gecrawld door zowel Googlebot Desktop en Googlebot Smartphone. Variaties op zijn crawlers die zijn ontworpen om verschillende informatie te verzamelen voor verschillende apparaten. Toen Google in 2018 mobile-first-indexering aankondigde voor zijn index, betekende dit dat websites met mobiele versies die versie standaard in zijn index zouden laten opnemen – een signaal aan online bedrijven en websites dat mobiel verkeer steeds dominanter werd.

Googlebot gebruikt verschillende “user-agents” om verschillende apparaten of technologieën na te bootsen, zodat het kan zien hoe webinhoud op die verschillende softwares verschijnt.

Via Seobility

Wat is Googlebot Smartphone? Hoeveel Googlebots zijn er eigenlijk?

Google heeft zestien verschillende bots die zijn ontworpen voor verschillende vormen van site-rendering en crawling. De waarheid is dat je voor SEO je site zelden anders hoeft in te richten voor een van deze. Elk van deze bots kan anders worden behandeld met behulp van uw robots.txt-bestand of uw meta-opdrachten, maar tenzij u richtlijnen voor een bepaalde bot specificeert, zullen ze allemaal op dezelfde manier worden behandeld.

Googlebot draait op Google’s Chromium rendering engine die van tijd tot tijd wordt bijgewerkt om ervoor te zorgen dat het in staat is om moderne website coderingsparameters en stijlen te begrijpen en om ervoor te zorgen dat het snel moderne pagina’s kan renderen.

Googlebot’s Chromium is wat google noemt een “evergreen” engine geworden, wat betekent dat het altijd de nieuwste Chromium gebaseerde engine zal draaien voor het renderen van websites zoals de Chrome browser dat doet (samen met andere user-agents voor verschillende andere veelgebruikte web browsers). Google’s langdurige doel is om in staat te zijn om websites en webpagina’s te renderen en te begrijpen op de manier waarop mensen dat doen, dit betekent dat Googlebot pagina’s zal begrijpen op vrijwel dezelfde manier als ze verschijnen in moderne webbrowsers.

Learn More

Dus wat is Googlebot in SEO? Neem contact met ons op voor meer info.

Bij Radd Interactive werkt ons analistenteam aan het uitvoeren van strategische optimalisaties die de prestaties van een site als geheel verbeteren, rekening houdend met de honger van Googlebot naar verse, relevante en gemakkelijk te verteren inhoud.

Optimalisatie voor de Googlebot-crawler helpt ervoor te zorgen dat uw website wordt gecrawld en geïndexeerd zowel grondig als efficiënt voor de best mogelijke resultaten.