Co to jest Googlebot? – Getting to Know Google’s Crawler

Google crawling i indeksowanie to terminy, które prawdopodobnie słyszałeś podczas nurkowania w głęboko dynamicznych wodach optymalizacji pod kątem wyszukiwarek. Prawdopodobnie słyszałeś również o botach wyszukiwarki Google, takich jak jej słynny Googlebot.

Ale czym jest Googlebot? I jak Googlebot działa w SEO?

Dla zespołu analityków Radd, indeks Google jest naszą siłą napędową, podobnie jak dla instytucji zajmujących się marketingiem internetowym na całym świecie. Jest to fundament, na którym opierają się nasze wysiłki. Mając to na uwadze, zamierzamy przyjrzeć się bliżej technicznym aspektom procesu indeksowania Google i zbadać sposoby, w jakie wpływa on na sukces firm i stron internetowych.

Dla firm, które chcą rozszerzyć swoją wydajność wyszukiwania i zwiększyć swoją obecność w Internecie, zrozumienie, jak działa Googlebot, może pomóc.

Co to jest indeksowanie i pełzanie Googlebota i jak to wpływa na moją witrynę?

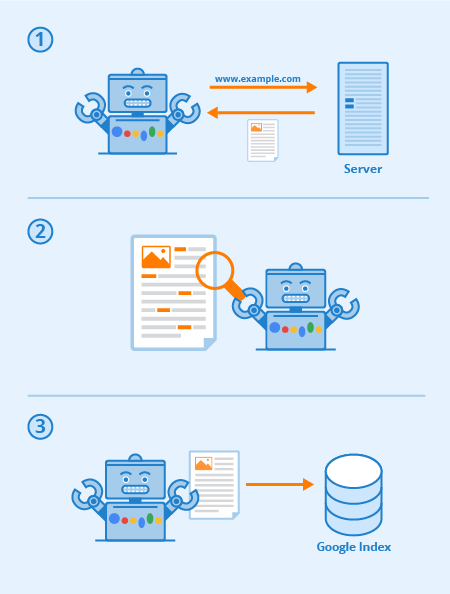

Googlebot to specjalne oprogramowanie, powszechnie nazywane pająkiem, zaprojektowane do pełzania po stronach publicznych witryn internetowych. Podąża on za serią linków od jednej strony do drugiej, a następnie przetwarza znalezione dane w zbiorczy indeks.

To oprogramowanie pozwala Google skompilować ponad 1 milion GB informacji w ciągu zaledwie ułamka sekundy. Wyniki wyszukiwania online są następnie pobierane bezpośrednio z tego indeksu. Zabawny i łatwy sposób myślenia o tym to jak o bibliotece z ciągle powiększającym się inwentarzem. Googlebot jest ogólnym terminem dla narzędzi, których używa do odkrywania zawartości stron internetowych, zarówno w ustawieniach desktopowych jak i mobilnych.

Mając to na uwadze, czym jest Googlebot w kontekście SEO?

Strategiczna optymalizacja stron internetowych działa w celu zwiększenia widoczności w wynikach wyszukiwania. Sposób, w jaki Twoja witryna jest odwzorowana za pomocą linków tekstowych, może znacznie zwiększyć ogólną skuteczność przeszukiwania jej przez Googlebota. Istotne praktyki SEO obejmują techniki optymalizacji ukierunkowane zarówno na Googlebota, jak i na strony wyników wyszukiwania (SERP).

W ostatecznym rozrachunku, im bardziej przejrzysta i zwięzła jest Twoja sitemapa i treść, tym bardziej widoczne będą Twoje strony.

Każda wyszukiwarka (i wiele innych stron internetowych) ma boty, a Googlebot jest Google. Googlebot jest botem indeksującym, który w prostych słowach przechodzi od linku do linku próbując odkryć nowe adresy URL do swojego indeksu.

Oto jak działa Googlebot: linki są krytyczne dla umożliwienia mu przechodzenia ze strony na stronę (i mogą to być dowolne linki) – linki obrazkowe, nav-bar, anchor-text, a nawet linki ukryte za pomocą odpowiednio czytelnego JavaScript.

Kiedy strony te są odkrywane, ich zawartość jest renderowana przez Googlebota i odczytywana tak, aby wyszukiwarka mogła określić ich tematykę, jak również wartość dla wyszukiwarek. Właściwa strategia SEO oznacza, że strony z dobrą strukturą, szybkim czasem ładowania i zrozumiałą treścią są łatwe do przyswojenia dla Googlebota i mogą pomóc w SEO strony.

Via Seobility

Co to jest crawlability strony internetowej?

Crawlability odnosi się do stopnia dostępu Googlebota do całej witryny. Im łatwiej jest oprogramowaniu przeczesać Twoją zawartość, tym lepsza będzie Twoja wydajność w SERPach.

Jednakże możliwe jest, że roboty indeksujące mogą zostać zablokowane, jeśli nie z Twojej witryny jako całości, to na pewno z wybranych stron. Wspólne problemy, które mogą negatywnie wpłynąć na indeksowanie to komplikacje z DNS, źle skonfigurowany firewall lub program ochronny, a czasem nawet system zarządzania treścią. Należy zauważyć, że można osobiście manipulować, które strony Googlebot może czytać, a których nie, ale należy zachować szczególną ostrożność, aby najważniejsze strony nie zostały zablokowane.

Co mogę zrobić, aby zoptymalizować moją witrynę dla Googlebota?

Oto kilka wskazówek i sugestii dotyczących optymalizacji witryny dla Googlebota:

- Twoja treść musi być łatwo widoczna w przeglądarce tekstowej, więc nie komplikuj jej zbytnio. Googlebot ma trudności z indeksowaniem stron, które wykorzystują programy takie jak Ajax i (czasami) JavaScript. Jeśli masz wątpliwości, zachowaj prostotę.

- Używaj stron kanonicznych, aby pomóc Googlebotowi znaleźć właściwą wersję zduplikowanych stron. Dla wielu stron internetowych powszechne jest posiadanie wielu adresów URL dla tej samej strony. Nowoczesny Googlebot jest nawet w stanie wiedzieć, kiedy to się dzieje, ale posiadanie wielu zduplikowanych stron na wielu adresach URL może czasami dezorientować Googlebota, spowalniać jego szybkość indeksowania i zmniejszać budżet na indeksowanie. Dlatego właśnie kanonizacja jest najlepszą praktyką SEO w większości przypadków.

- Prowadź Googlebota przez swoją witrynę za pomocą pliku robots.txt lub znaczników meta robots. Blokowanie crawlera przed nieistotnymi stronami spowoduje, że oprogramowanie poświęci swój czas na bardziej wartościowe treści i pomoże mu zrozumieć strukturę witryny. (W ostatnich latach Google zmniejszyło wpływ robots.txt na blokowanie stron z indeksu, który już nie działa dla niektórych, najlepszą praktyką jest używanie dyrektyw “no-index” zamiast tego)

- Świeża treść. Google uwielbia świeże i istotne treści. Aktualizowanie starych stron lub tworzenie nowych będzie iskrzyć zainteresowanie crawlera. Im częściej jesteś indeksowany, tym większe masz szanse na zwiększenie wydajności. Jednakże, ma to zastosowanie tylko tak długo, jak długo dokonujesz wysokiej jakości aktualizacji. Zawsze upewnij się, że twoja kopia jest dobrze napisana i nie jest przepełniona słowami kluczowymi. Źle napisana treść będzie miała tylko negatywny efekt.

- Łączenie wewnętrzne. Linkowanie wewnętrzne za pomocą linków anchor text, lub ATL, pomaga skierować crawlera przez Twoją witrynę. Ściśle skonsolidowany system linkowania może sprawić, że indeksowanie Googlebota będzie o wiele bardziej efektywne. Podczas pisania ATL-ów należy być rozważnym. Linkuj tylko do stron, które są istotne dla Twojej treści lub produktu, i upewnij się, że miejsce docelowe nie może być w inny sposób dostępne z paska nawigacyjnego bieżącej strony.

- Przesyłanie sitemapy. Sitemapy są pliki hostowane na serwerze witryny, które lista wszystkich adresów URL witryny (lub wszystkie z tych, które właściciele witryn wybrać do włączenia co najmniej). Sitemapy są dobre dla SEO, ponieważ dają Googlebotowi łatwą do znalezienia i łatwą do strawienia listę wszystkich najbardziej wartościowych stron. Z sitemap, witryny prawdopodobnie będą indeksowane szybciej i częściej.

Wykonanie witryny w Google jest wielowarstwowe, i ważne jest, aby pamiętać, że Googlebot jest zawsze crawling.

Różne rodzaje Googlebots

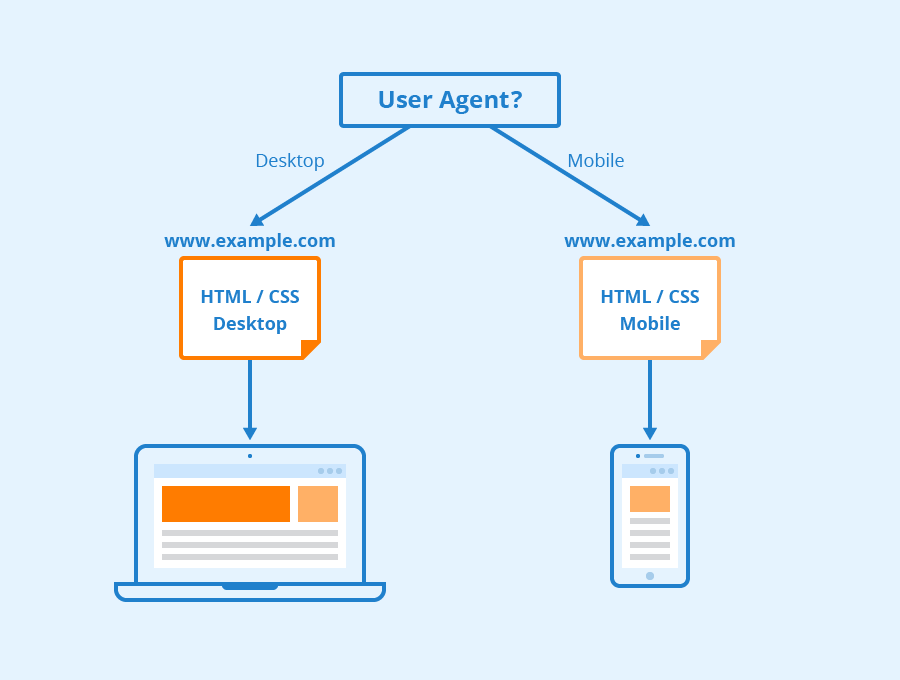

Według Google wszystkie strony internetowe są prawdopodobnie będzie crawled przez obu Googlebot Desktop i Googlebot Smartphone. Wariacje na temat swoich crawlerów, które są przeznaczone do zbierania różnych informacji dla różnych urządzeń. Kiedy Google ogłosił mobile-first indexing dla swojego indeksu w 2018 roku, oznaczało to, że strony internetowe z wersjami mobilnymi będą miały tę wersję domyślnie wprowadzoną do swojego indeksu – sygnalizując firmom internetowym i stronom internetowym, że ruch mobilny staje się coraz bardziej dominujący.

Googlebot używa różnych “user-agentów” do naśladowania różnych urządzeń lub technologii, dzięki czemu może zobaczyć, jak zawartość strony internetowej pojawia się dla tych różnych softów.

Via Seobility

Co to jest smartfon Googlebot? W rzeczywistości, ile jest Googlebotów?

Google ma szesnaście różnych botów przeznaczonych do różnych form renderowania strony i indeksowania. Prawda jest taka, że dla SEO rzadko kiedy trzeba skonfigurować witrynę inaczej dla któregokolwiek z nich. Każdy z tych botów może być obsługiwany inaczej za pomocą pliku robots.txt lub poleceń meta, ale jeśli nie określisz dyrektyw dla konkretnego bota, wszystkie będą traktowane w ten sam sposób.

Googlebot działa na silniku renderującym Google Chromium, który jest aktualizowany od czasu do czasu, aby zapewnić, że jest w stanie zrozumieć nowoczesne parametry i style kodowania stron internetowych i zapewnić, że może szybko renderować nowoczesne strony.

Googlebot’s Chromium stał się tym, co google nazywa “wiecznie zielonym” silnikiem, co oznacza, że zawsze będzie uruchamiał najnowszy silnik oparty na Chromium do renderowania stron internetowych w taki sam sposób, w jaki robi to przeglądarka Chrome (wraz z innymi agentami użytkownika dla różnych innych popularnych przeglądarek internetowych). Od dawna celem Google jest możliwość renderowania i rozumienia witryn i stron internetowych w sposób, w jaki robią to ludzie, oznacza to, że Googlebot będzie rozumiał strony w taki sam sposób, w jaki pojawiają się one w nowoczesnych przeglądarkach internetowych.

Dowiedz się więcej

Czym więc jest Googlebot w SEO? Skontaktuj się z nami, aby uzyskać więcej informacji.

W Radd Interactive nasz zespół analityków pracuje nad przeprowadzeniem strategicznych optymalizacji, które poprawiają wydajność witryny jako całości, biorąc pod uwagę apetyt Googlebota na świeżą, istotną i łatwą do strawienia treść.

Optymalizacja dla robota indeksującego Googlebot pomaga zapewnić, że Twoja witryna jest indeksowana i przeszukiwana zarówno dokładnie, jak i wydajnie, aby uzyskać najlepsze możliwe wyniki.

Optymalizacja dla robota indeksującego Googlebot pomaga zapewnić, że Twoja witryna jest przeszukiwana i indeksowana zarówno dokładnie, jak i wydajnie, aby uzyskać najlepsze możliwe wyniki.